本周,我們發布了模型功能 DBRX,這是由 Databricks 開發的最先進的大型語言模型(LLM)。DBRX 在編程和編碼任務方面展示出了強大的實力,擅長使用 Python 等語言處理專門的主題和編寫特定的算法。此外,它還可以應用于文本完成任務和少回合交互。DBRX 的長上下文能力可用于 RAG 系統,以提高準確性和保真度。

模型對細粒度的使用 混合專家(MoE) 體系結構是它區別于其他模型的一個關鍵特性。該 MoE 架構通過利用一組專門的“專家”網絡,擅長處理復雜任務。在推理過程中,MoE 使用學習的門控機制,基于輸入數據動態選擇并組合這些專家網絡的輸出,以實現更好的性能。

這種門控機制將輸入數據的不同部分路由到最相關的專家網絡,使教育部能夠有效地利用其集體專業知識并產生卓越的預測或輸出。通過自適應地協調其組成網絡的貢獻,MoE 在有效利用計算資源的同時,在不同任務上實現了卓越的性能。

DBRX 細粒度 MoE 方法使用了更多更小的專家,從而提高了性能和效率。該體系結構共涉及 1320 億個參數,在任何給定時間都有 360 億個活動參數,通過使用 16 名專家進行管理,其中四名專家為每個處理的代幣激活。

DBRX 針對延遲和吞吐量進行了優化,使用 NVIDIA TensorRT LLM。現在,它已經加入了二十多個流行的人工智能模型,這些模型由 NVIDIA NIM 微服務提供,旨在簡化性能優化的部署。NIM 支持 NVIDIA AI Foundation 模型 和自定義模型的部署,使得 10 到 100 倍的企業應用程序開發人員能夠為人工智能轉型做出貢獻。

NVIDIA 正與領先的模型構建商合作,在完全加速的堆棧上支持他們的模型。其中包括流行的型號,如 Llama3-70B、Llama3-8B、Gemma2B、Mixtral 8X22B 等。您可以訪問 ai.nvidia.com,在企業應用程序中體驗、定制和部署這些模型。

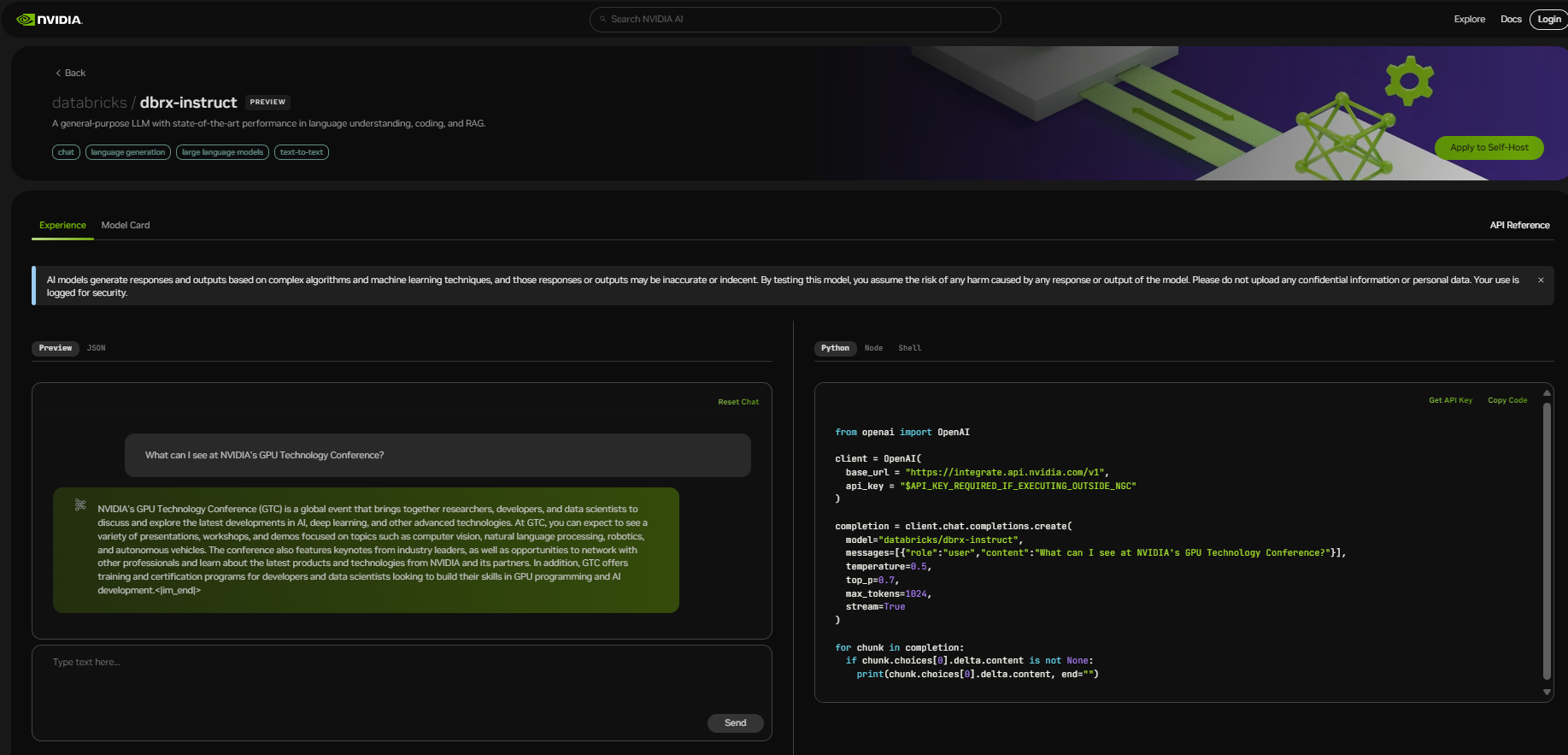

開始使用 DBRX

開始體驗 DBRX,請訪問 build.nvidia.com。使用免費的 NVIDIA 云積分,您可以開始大規模測試模型,并通過將應用程序連接到運行在完全加速堆棧上的 NVIDIA 托管 API 端點上來構建概念驗證(POC)。