自從引入并隨后廣泛采用大型語言模型(LLM)以來,數據一直是企業構建準確安全的人工智能系統的生命線。一家公司的數據代表了其累積的知識,可以通過各種方式加以利用,從定制(監督微調、參數高效微調、持續預訓練等)到訓練全新的特定領域小型語言模型(SLM)。數據雖然是現代人工智能管道中最關鍵的部分之一,但在創新 LLM 和 SLM 的開發過程中,傳統上成本高昂且受到限制的是從付費人工注釋到導航大量特定領域數據的來源,當前生成高質量數據的過程是一項艱巨的任務。

通過一個稱為合成數據生成(SDG)的過程,該過程將在博客的其余部分中更仔細地定義,企業可以通過利用 LLM 創建大量定制的高質量數據來增強現有的數據存儲。

NVIDIA 宣布了一套專門為 SDG 構建的新模型系列——Nemotron-4 340B family,包括最先進的 Reward Model 和一款 Instruct 模型,以助力 SDG,所有這些模型都是在許可證下發布的,這將使企業和開發者都能夠使用模型輸出來構建令人難以置信的模型。

NVIDIA 開放式模型許可證

隨著 Nemotron-4 340B 型號系列(包括基礎型號、指導型號和獎勵型號)的發布,NVIDIA 推出了NVIDIA 開放模型許可證

Nemotron-4 340B 獎勵模型介紹

Nemotron-4 340B 獎勵模型是一種最先進的多維獎勵模型,該模型以文本提示作為輸入,并返回與 HelpSteer2 數據集中的五個屬性相關聯的浮點數列表如下所示。

該模型已使用Reward Bench進行評估,盡管只包含 10K 個人工注釋的響應對,但仍能顯示出基準最高性能。

在給定提示的情況下,獎勵模型可以根據人類偏好為響應提供分數,也就是說它可以與人類對給定提示的偏好保持一致,因此能夠替換大量的人類注釋。最新發布的 Nemotron-4 340B Reward 以 92.0 的總分領跑 Reward Bench。值得注意的是,Nemotron-4 340B Reward 在 Chat-Hard 中領先最顯著,以近七個百分點的優勢擊敗了排名第二的替代品。Chat-Hard 是測試數據的一個子集,用于評估“獎勵模型理解技巧問題和微妙不同的教學反應的能力”。 (RewardBench paper)

HelpSteer2 數據集

隨著 Nemotron-4 340B 獎勵的發布,我們還推出了 HelpSteer2,該數據集是許可的(CC-BY-4.0),具有一萬個響應對,每個提示都包含兩個響應,這些響應使用 Likert-5 量表(從 0 到 4,含義越高越好)對五個屬性進行人工注釋。

- 幫助:對提示的響應的總體幫助性。

- 正確性:包含所有相關事實,無誤。

- 一致性:表達的一致性和清晰度。

- 復雜性撰寫回復所需的智力深度(即回復是否可以由具有基本語言能力的人撰寫或需要深入領域的專業知識)。

- 詳細程度:相對于提示中要求的內容,響應中包含的詳細信息量。

該數據集中于會話數據,包括英語中的多回合會話。

有關數據集的更多詳細信息,請參閱HelpSteer2 數據集論文。

SteerLM 獎勵模型訓練

Nemotron-4 340B 獎勵模型是在 Nemotron-4 340B 基礎模型上訓練的,該基礎模型具有額外的線性層,該線性層將響應結束令牌的最終層表示轉換為五個標量值,每個標量值對應于HelpSteer屬性,稱為 SteerLM 獎勵模型訓練有關培訓過程的更多詳細信息可以在HelpSteer2 論文中找到

與基于二元偏好的方法不同,SteerLM 獎勵模型訓練過程允許模型提供更具表現力的反饋,說明哪些響應被認為是好的以及為什么。二進制訓練的獎勵模型有時可能會將長響應與好響應混為一談,而 SteerLM 獎勵模型訓練則明確教導模型將冗長性作為得分屬性來消除歧義。

合成數據生成入門指南

在我們說明開發人員如何利用 Nemotron-4 340B 系列模型進行合成數據生成之前,我們首先提供一個引物。SDG 是指創建可用于各種模型自定義的數據集的過程,從監督微調(SFT),參數高效微調(PEFT)包括低秩自適應(LoRA),和模型對齊(使用方法如RLAIF,DPO,等)。此外,SDG 的用例并不局限于模型對齊,而是可以應用于廣泛的應用,從檢索到評估數據集管理,再到推薦系統。在這篇博客文章中,我們將重點關注模型對齊,將其作為 Nemotron-4 340B 模型系列的主要用例。對齊訓練是生成人工智能領域中一個快速發展的子學科,可以通過幾種不同的方式實現。在現有方法中,我們將討論一個 SDG 管道的具體實施,如下所述。

至關重要的是,穩健的 SDG 方法不僅僅生成響應數據,還包括驗證和檢查,以確保數據質量保持較高水平。LLM 的準確性通常直接由訓練數據的質量而非數量決定,使得“質量過濾”步驟在 SDG 配方中至關重要。

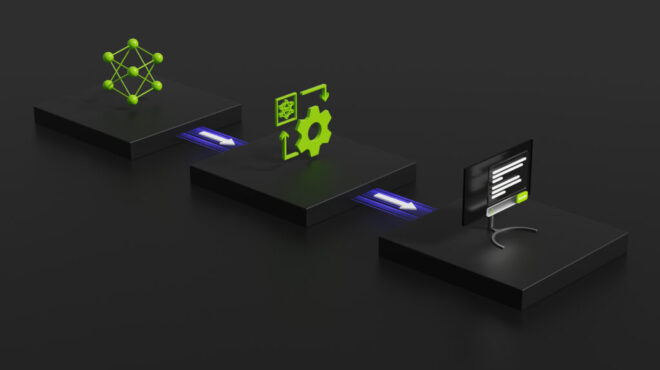

一種合成數據生成流程

一般而言,可持續發展目標分為兩個主要部分,概述如下。

- 合成響應生成

合成響應數據可以通過給出 Nemotron-4 340B 指令域特定輸入查詢來生成,這允許模型生成與輸入查詢對齊的響應,其格式類似于GPT-4 論文中的“指令調整”中使用的格式。這些響應可以根據所需的響應格式通過零樣本、少量快照或思想鏈式提示生成;如果需要,還可以生成對每個查詢的多個響應,以便在下一步進行篩選。

注:Nemotron-4 340B 指令模型也可以最初生成特定于域的查詢,從而減少對預先建立的查詢數據集的需求,因為這可以減少對預先建立的查詢數據集的需求。但是,這種用例并未在教程材料中涵蓋。

- 獎勵模型驗證

由于 Nemotron-4 340B 獎勵的多屬性特性,合成響應可以根據最需要的 HelpSteer2 屬性排名,以便只保留性能最高的響應,這模擬了提示質量的人工評估過程,并在 SDG 管道中添加了一層質量監控。

個案研究:

NVIDIA 的研究人員能夠在HelpSteer2論文中證明 SDG 的有效性。通過上述管道總共創建了10 萬行會話合成數據(在以下基準中稱為“Daring Anteater”或“DA”)。使用該數據集,NVIDIA 研究團隊能夠在許多標準基準上調整 Llama 3 70B(基本模型),以匹配或超過 Llama 3 70B Instruct。盡管只使用了Llama 3 70B Instruct 模型訓練的 1%的人類注釋數據,但還是實現了這一點。

結果展示了 SDG 的有效性,以及如何使用 Nemotron-4 340B Reward 和 Nemotron-4-340B Instruction 等工具為當今企業的數據管道增加價值。

值得注意的是,有許多 SDG 管道,這仍然是一個活躍的研究主題。Nemotron-4 340B Instruct 本身使用類似于圖 3 所示流程的 SDG 管道變體進行了訓練,其 98%的對準訓練數據是綜合生成的(在技術報告中了解更多信息)。我們鼓勵開發人員評估和開發不同的管道,并分享最佳實踐,同時繼續完善我們自己的 SDG 方法。

數據是 LLM 的主干。NVIDIA 認識到合成數據生成是企業 Gen AI 應用程序改善的下一個前沿,因此提供了 Nemotron-4 340B 系列模型和 SDG 管道,使開發人員和企業都能通過許可證和最高質量的公開指導模型和獎勵模型之一,為廣泛的合成數據用例加速。

關于如何部署模型的說明可在其各自的模型卡上獲得,NeMo Framework 說明可用于Nemotron-4 340B Base和Nemotron-4 340B InstructNemotron-4 340B Reward。

在接下來的幾周里,我們將發布 Nemotron-4 340B NIMs,用于在NVIDIA GPUs 上進行優化的推理,以及一份技術演練,包括創建上述 SDG 管道的教程。

通過這里嘗試通過此處提供的預覽推理 API 指導 Nemotron-4 340B Instruct。

?