近年來,大型語言模型(LLM)徹底改變了自然語言處理(NLP),實現了文本摘要、問答和自然語言生成等廣泛的應用。

由 Snowflake 開發的 Arctic 是一種新的開放 LLM,旨在實現高推理性能,同時在各種 NLP 任務上保持低成本。

Arctic

Arctic 基于一種新的密集 MoE(專家混合物)混合變壓器架構,該架構將 10B 參數密集變壓器模型與殘差 128×3.66B MoE 多層感知器(MLP)相結合,從而有效地隱藏普通 MoE 模型在計算過程中施加的額外全對全通信開銷。這樣,該體系結構能夠在訓練和推理過程中更有效地使用資源。

由此產生的網絡具有 480B 的總參數,并使用前 2 個門控讓專家選擇 17B 的活動參數。通過利用大量專家和總參數,該體系結構允許頂級智能,同時從許多但精簡的專家中進行選擇,僅使用適量的活動參數進行訓練和具有成本效益的推理。

LLM 在企業中的應用案例

Arctic 的主要用例是 SQL、編碼和企業應用程序的指令遵循。

SQL 和代碼生成具有挑戰性,因為它需要理解自然語言和編程語言的語義和語法,并生成符合用戶意圖的有效和準確的輸出。

該模型擊敗了其他最先進的開放模型,在 Spider 基準測試中實現了 79%的準確率,Spider 基準是一個大規模、復雜和跨領域的語義解析和文本到 SQL 數據集,旨在評估模型將自然語言問題翻譯成 SQL 查詢的能力。

此外,它在用于代碼生成的 HumanEval+和 MBPP+基準測試中處于領先地位,并在 IFEval 基準測試中提供了優于其他模型的性能——用于評估 LLM 的指令遵循能力的性能。

NVIDIA NIM 微服務平臺

Arctic 針對延遲和吞吐量進行了優化,現在加入了二十多個受支持的流行人工智能模型,包括 NVIDIA NIM 微服務,旨在簡化性能優化部署,以及 NVIDIA AI Foundation 模型 和自定義模型,使更多的企業應用程序開發人員能夠為人工智能轉型做出貢獻。

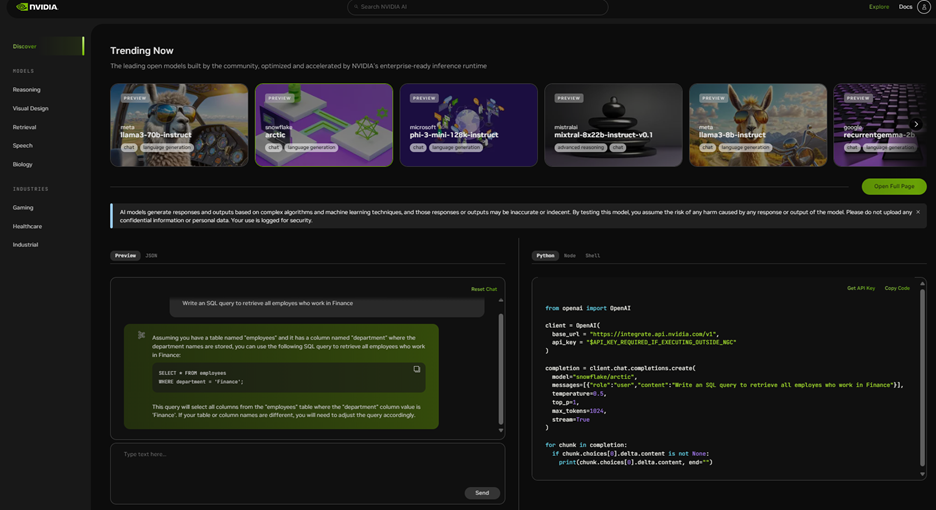

體驗模型 Demo

NVIDIA API 產品目錄 是一組性能優化的 API 端點,打包為企業級運行時,允許您在瀏覽器中進行體驗和探索。

有了免費的 NVIDIA 云積分,您可以開始大規模測試該模型。您還可以通過將應用程序連接到運行在完全加速堆棧上的 NVIDIA 托管 API 端點上來構建概念驗證(POC)。API 與 Langchain 和 LlamaIndex 等框架集成,簡化了企業應用程序開發。

當您準備將其投入生產時,可以在幾分鐘內將模型部署到本地、云中或工作站上的 NIM 微服務中。隨時隨地運行的靈活性使您的數據保持安全和隱私,避免平臺鎖定,并使您能夠利用現有的基礎設施投資和云承諾。

要開始,請訪問 build.NVIDIA.com,立即開始您的開發之旅。

?