檢測可駕駛自由空間是高級駕駛員輔助系統( ADAS )和自動駕駛汽車( AV )感知的關鍵組成部分。障礙物檢測通常用于檢測一組特定的動態障礙物,如車輛和行人。

相比之下,自由空間檢測是一種更通用的障礙物檢測方法。它使自動駕駛汽車能夠安全地繞過許多類型的障礙物,如樹木或路緣石,即使沒有經過明確的訓練來識別特定的障礙物類別。

傳統上,攝像機系統已經被用來解決這一任務。然而,在惡劣的天氣和弱光條件下,或者在識別距離車輛更遠的物體時,攝像頭的感知性能可能會受到影響。為了克服這些挑戰,我們開發了一種使用雷達的自由空間探測系統。它在應對天氣和照明挑戰方面非常強大,并且能夠直接測量距離。

我們的系統作為 ADAS 和 AV 感知的一部分工作,以檢測可駕駛的自由空間,并在多傳感器融合過程中進一步改善 3D 感知。更具體地說, RadarNet 是一種深度神經網絡( DNN ),它使用汽車雷達傳感器檢測動態障礙物和可駕駛的自由空間。有關更多詳細信息,請參見 NVRadarNet: Real-Time Radar Obstacle and Free Space Detection for Autonomous Driving 。

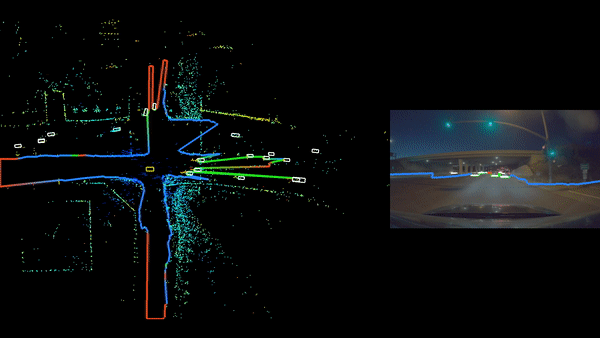

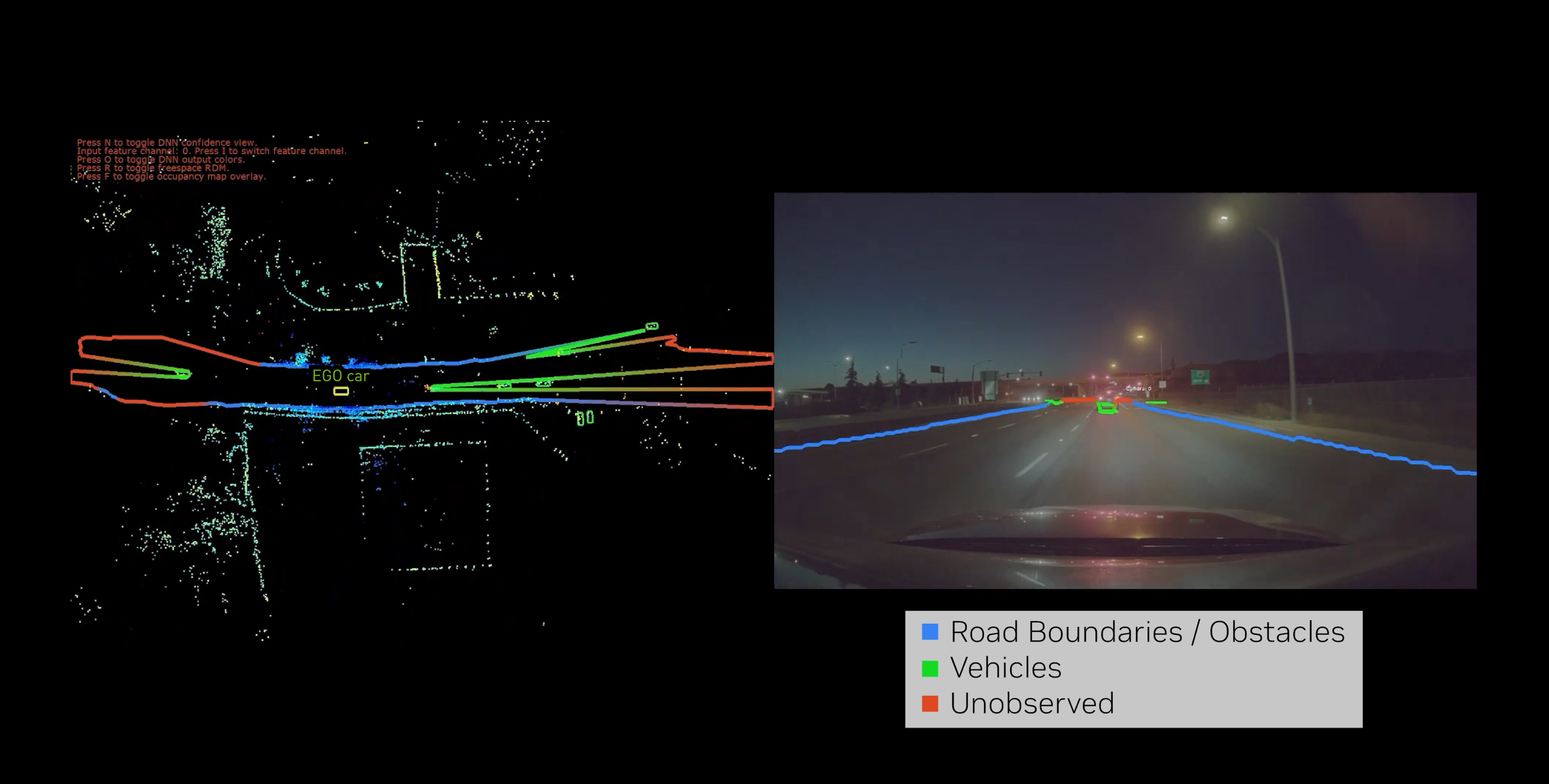

在下面的 NVIDIA DRIVE Dispatch 視頻中觀看 RadarNet 深度神經網絡的運行示例。

視頻 1 。觀看 RadarNet 深度神經網絡的運行示例

密集占用概率表示

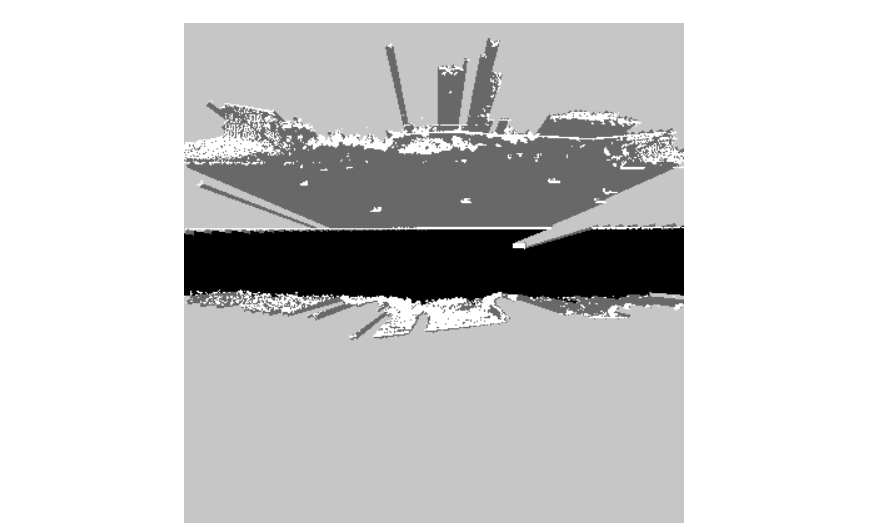

由于雷達檢測的稀疏性,傳統的雷達感知算法難以單獨使用雷達數據對可驅動自由空間進行魯棒分類。為了克服這一挑戰, RadarNet 能夠在 2D 鳥瞰圖( BEV )中回歸密集占用概率圖。這種方法受到了 Probably Unknown: Deep Inverse Sensor Modelling Radar 中介紹的工作的啟發。

這些標簽是通過首先結合現有的人類標記的 3D 障礙物和自由空間標簽生成的,然后使用從原始激光雷達點云中得出的觀測值進行自動占用計算。從車輛原點到每個障礙物的光線追蹤能夠推理哪些區域是:

- 觀察和自由

- 觀察到并占用

- 未觀測到的

- 部分觀察到

對 DNN 進行訓練,以輸出以下占用預測:

- 直接觀察到并被占用的區域的高概率

- 直接觀察到并且沒有任何障礙物的區域的低概率

- 對于未觀測到的區域,保持明確不確定的中等概率,輸出概率( p = 0.5 )

觀察到的和被占領的區域可以進一步細分為其他類別,例如動態障礙類別。甚至可以通過激光雷達傳感器的后處理信息將區域標記為升高。這導致了具有以下分類的分割圖:

- 動態障礙物(車輛、行人)

- 一般非駕駛障礙物(護欄、灌木、燈桿)

- 可行駛障礙物下的一般情況(橋梁、道路上方的樹木)

- 未觀測到的

占用概率圖與目標檢測一起訓練,作為 RadarNet DNN 的額外任務負責人。這樣做可以保證這些任務之間的一致性,并降低總體計算需求。與原始 RadarNet 相比,總延遲增加不超過 10% 。

可驅動自由空間徑向距離圖的提取

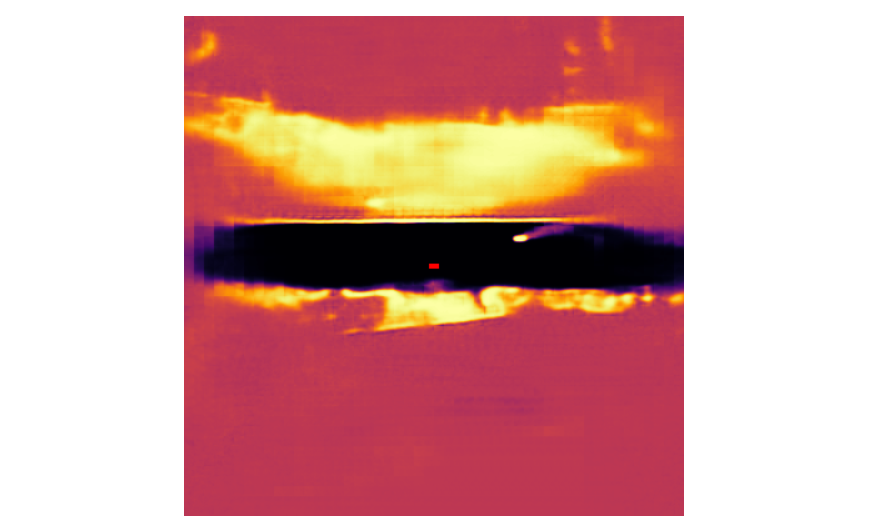

可以對這種密集占用概率表示進行進一步的后處理,以檢測可驅動的自由空間邊界。這是通過在所有方位方向上追蹤來自車輛原點的光線來完成的,直到占用概率達到某個閾值。

特別地,首先將笛卡爾 BEV 占用概率圖重新采樣到以車輛原點為中心的極坐標系中。其次,我們在所有角度方向上迭代,將高于所需概率閾值的第一個 bin 標記為該角度的最終邊界。通過預先計算笛卡爾到極坐標的重采樣網格,然后進行最近鄰插值,可以進一步優化這一過程。最終的徑向距離圖( RDM )輸出顯示為 ego 車輛周圍的一組多段線。

結論

本文中介紹的僅限雷達驅動的自由空間檢測器預測了密集的占用概率,可以以顯著的精度穩健地檢測自由空間邊界,同時運行速度足夠快,可以輕松地與 NVIDIA DRIVE AGX Orin 上的 NVIDIA AV 堆棧的其余部分放在一起。

目前的雷達網同時支持動態物體檢測和可驅動自由空間檢測。物體檢測被分為多個類別,例如汽車、自行車和行人。占用區域被進一步劃分為高架、非高架或未觀測區域。然后, RadarNet 的輸出被用作具有基于相機的檢測器的多傳感器融合系統的輸入,從而提高 AV 的魯棒性。

有關更詳細的解釋,請參見 NVRadarNet: Real-Time Radar Obstacle and Free Space Detection for Autonomous Driving 。要了解有關軟件功能的更多信息,請參閱 Perceiving with Confidence: How AI Improves Radar Perception for Autonomous Vehicles from the NVIDIA DRIVE Lab 系列視頻和 NVIDIA DRIVE Dispatch 描述 RadarNet 空閑空間的視頻。

Register for NVIDIA GTC 2023 for free ,并于 3 月 20-23 日加入我們,了解更多鼓舞人心的內容和相關的專家主導的會議。

?

?