合成數據并不是創建新信息,而是將現有信息轉換為不同的變體。十多年來,合成數據一直用于全面提高模型準確性,無論是轉換圖像以改進對象檢測模型、加強欺詐性信用卡檢測,還是改進BERT模型以實現問答。

有什么新功能?隨著大型語言模型(LLMs)的出現,生成合成數據的動力和生成合成數據的技術都得到了大幅提升。

各行各業的企業都在生成合成數據,以針對各種用例微調基礎語言模型,例如改善金融領域的風險評估、優化零售業供應鏈、改善電信領域的客戶服務,以及推進醫療健康領域的患者護理。

今天,Meta 發布了 Llama 3.1 405B,這是一款功能強大的開放語言模型(LLM),可用于批量和在線推理。它還可以作為基礎,針對特定領域進行專門的預訓練或微調。鑒于模型的大小及其訓練的數據量,它非常適合生成合成數據。

在這篇博客文章中,我們將涵蓋幾個合成數據生成的應用案例,并深入探討其中的一個。

適用于生成式 AI 的 LLM 驅動的合成數據

我們來看看生成式 AI 空間中合成數據的一些高級應用案例,您可以在其中使用 Llama 3.1 405B 開始使用。

使用 LLM 生成的合成數據來改進語言模型

在生成用于調整模型的合成數據時,我們通常考慮兩種方法:知識提煉和自我完善。

知識提煉是將較大模型的功能轉換為較小模型的過程。這不是通過在同一數據集上訓練兩個模型就能實現的,因為較小的模型可能無法“學習”基礎數據的最準確表示。在這種情況下,我們可以使用較大的模型來解決任務,并使用該數據使較小的模型模仿較大的模型。

自我改進涉及使用同一模型來批評自己的推理,并且通常用于進一步磨練模型的功能。這兩種方法都可用于利用 Llama 405B 模型來改進較小的語言模型。

我們來看看如何實現這一點。訓練語言模型(LLM)涉及三個步驟:預訓練、微調和對齊。

預訓練:這涉及使用超大型信息語料庫來訓練模型,以了解語言的一般結構是如何組織的。對于通用語言模型,這通常是使用互聯網級數據完成的,而對于任何特定領域的語言模型,我們需要將細節融入該領域 (例如,用于幾何的語言模型、用于放射學的語言模型和用于電信的語言模型)。這稱為域自適應預訓練 (DAPT)。在預訓練階段應用合成數據的另一個示例是熱門的 Phi-1.5 模型,其中使用大型模型來合成數據,以便在預訓練階段注入邏輯推理。

微調:在模型針對通用語言結構訓練后,下一步是對其進行微調,以遵循特定指令。例如,調整模型以更好地閱讀理解類型的提取問題、改進邏輯推理、實現更好的代碼生成和函數調用屬于此類別。Self-Instruct、WizardCoder、Alpaca 等采用這些技術來創建特定于任務的微調數據。請參閱此示例,了解如何管理特定領域的數據,以了解更多信息。

對齊:最后,我們希望確保 LLM 響應的風格和色調與用戶的期望保持一致,例如聽起來是對話式的,具有適當的詳細程度、復雜性、一致性和其他用戶定義的屬性。為實現這一點,可以使用包含指令模型和獎勵模型的管道。具體來說,聊天模型會創建多個響應,而獎勵模型則提供有關響應質量的反饋。這項技術屬于從 AI 反饋中強化學習(RLAIF)的范疇。本 notebook 將向您介紹如何使用新的 Llama 405B 模型和 NVIDIA 340B Reward 模型為模型對齊生成合成數據。

使用 LLM 生成的合成數據來改進其他模型和系統

由于合成數據的應用空間非常廣泛,我們將重點討論與大語言模型相鄰的模型和由大語言模型驅動的流程。

檢索增強生成 (RAG) 使用嵌入模型檢索相關信息,并使用大語言模型 (LLM) 生成答案。嵌入模型為文本語義生成數學表示。我們可以使用大語言模型解析基礎文檔和合成數據,以評估和微調 嵌入模型。

與 RAG 類似,可以評估任何智能體流程并對其組件模型進行微調。這可以通過使用 LLM 驅動的智能體構建模擬來實現。 這些模擬還可用于研究 行為模式。此外,可以將用戶角色引導到 LLM 中,以大規模生成特定于任務的數據。

用于評估 RAG 的合成數據

為了具體化上述討論,讓我們思考一下上述用例之一的基本工作流,即生成用于檢索的評估數據。請遵循此 notebook。

評估檢索流程所面臨的主要挑戰是:

- 多樣性:問題不應該只關注信息的一個方面,也不應該只關注抽象信息。

- 復雜性:生成的問題應該需要一些推理或多種證據來回答問題。

我們將重點關注多樣性,但要探索復雜性的角度,關鍵在于找到包含重疊信息點的數據塊。找到重疊信息的兩種方法是計算 Jaccard 相似性在句子級語義中,并利用長上下文模型從同一文檔中繪制數據塊之間的相關性。

多樣性來自不同的視角。例如,考慮以下段落。

?

The proposed acquisition of GreenTech Inc. by SolarPower Corporation stands as one of the most notable transactions in the renewable energy sector this year. Valued at $3 billion, the deal aims to combine GreenTech’s cutting-edge battery technology with SolarPower’s extensive solar panel manufacturing and distribution network. The anticipated operational synergies are expected to result in a 20% reduction in production costs and a 15% increase in revenue over the next two years. However, the transaction is under intense scrutiny from regulatory bodies due to potential antitrust concerns. The Federal Trade Commission (FTC) has indicated that the merger could potentially create a monopoly in the renewable energy storage market, potentially stifling competition and innovation.

SolarPower has committed to maintaining GreenTech’s research and development (R&D) center, which employs over 500 scientists and engineers, as an independent entity to preserve its innovative culture. Additionally, all existing employment contracts will be honored, alleviating concerns about potential layoffs. The merger agreement includes a $150 million breakup fee, payable to GreenTech if SolarPower fails to secure the necessary regulatory approvals, thereby mitigating financial risks for GreenTech should the deal fall through.

The agreement includes detailed representations and warranties, specifying the accuracy of financial statements, the absence of undisclosed liabilities, and compliance with applicable laws. It also entails a thorough indemnification process to protect both parties against potential breaches of these representations and warranties. SolarPower and GreenTech have agreed to covenants that restrict GreenTech from incurring new debt, issuing additional shares, or significantly altering business operations without SolarPower’s consent prior to the deal’s closure. These covenants are designed to preserve the value of GreenTech and ensure a smooth transition post-merger. The agreement further outlines a comprehensive due diligence process, including environmental assessments and audits of GreenTech’s intellectual property portfolio, to ensure all assets and liabilities are accurately accounted for before the finalization of the transaction.

The European Commission is also reviewing the merger to assess its impact on the EU market, particularly regarding competition and market dominance. This evaluation involves submitting detailed filings that include market analyses, competitive impact assessments, and economic justifications for the merger. The review process requires both companies to respond promptly to inquiries and provide comprehensive documentation. Additionally, to secure approval, SolarPower and GreenTech may need to make concessions, such as divesting certain business units or assets, to alleviate concerns about reduced competition. Ensuring compliance with the EU Merger Regulation involves not only addressing competitive effects but also ensuring that the merger aligns with broader EU policies on market fairness and consumer protection.

財務分析師對兩家公司在合并前后的財務表現感興趣。法律專家可能會對公司面臨的來自聯邦貿易委員會、歐盟和其他方面的法律審查感興趣。記者可能會希望了解主要要點。

所有這些都是有效的觀點和用戶角色,由于它們以不同的觀點接近相同的信息,因此評估流程也需要適應相同的信息。因此,我們設計一個流程,該流程將文檔和用戶角色作為輸入,并以用戶角色特有的語氣輸出問題。

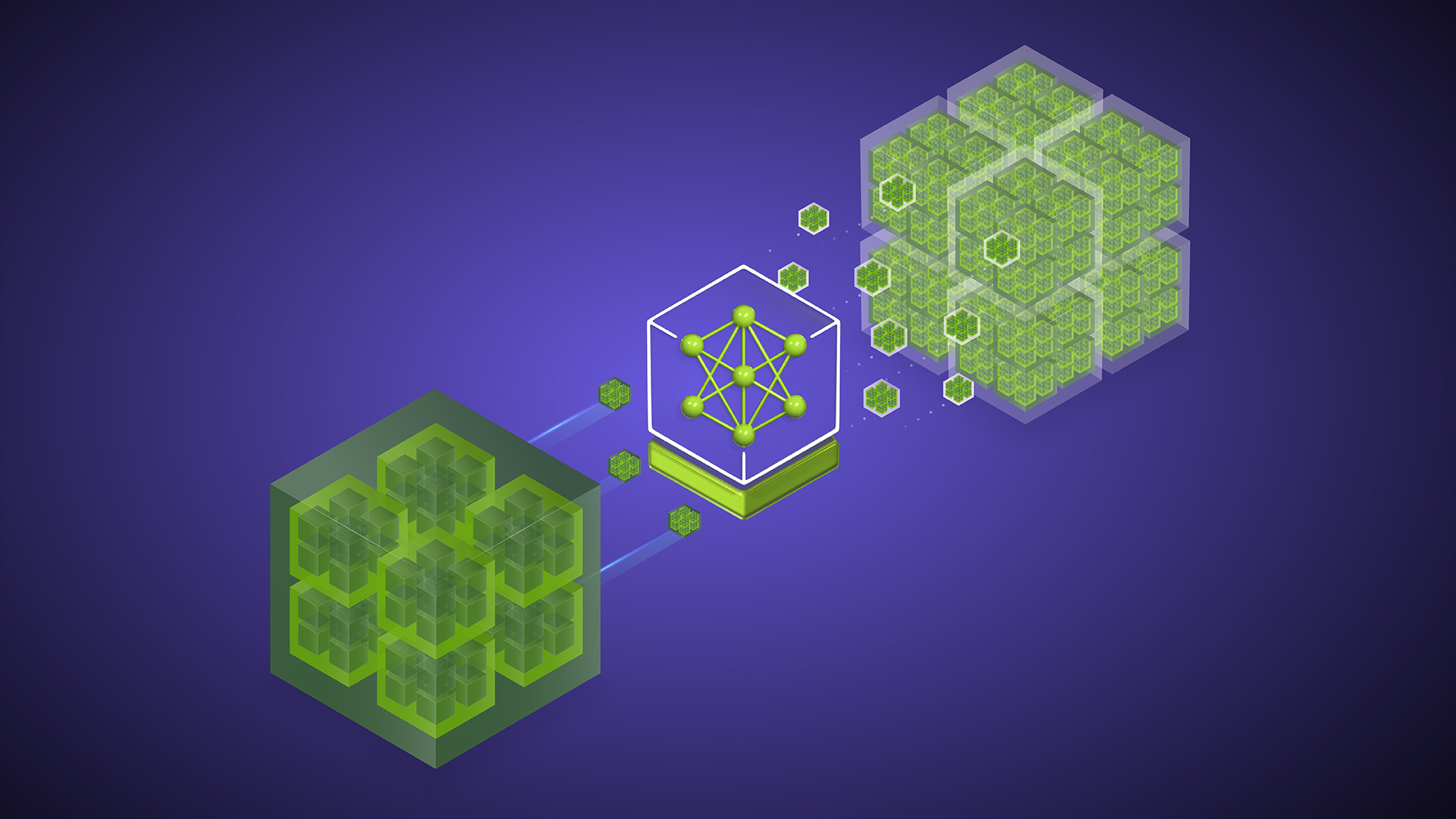

從概念上講,此管道有三個主要步驟,如圖 1 所示。

- 第 1 步:生成所有可能的問題,這些問題對人格角色感興趣。

- 第 2 步:篩選所有生成的問題。

- 第 3 步:介紹角色的寫作風格。

第 1 步:生成問題

在深入探討問題生成之前,我們需要攝取文檔并將其分割成塊。在本討論的其余部分中,讓我們將圖 1 作為文本的參考塊。

用戶角色只是對可能提出問題的用戶的描述。請參閱以下示例。

Persona 1

Joan 是一位非常資深的金融分析師,專注于使用計量經濟學來推薦投資策略。由于 Joan 習慣了擁有一個分析師團隊,可以向他們詢問信息,因此他們可能不太了解最新的細節,從而提出模糊的問題。但是,他們對一般主題非常了解。

Persona 2

Padma 是一位經驗豐富的公司訴訟律師,在處理大型公司復雜的法律案例方面擁有 10 多年的經驗。她以其務實的方法和銳利的分析頭腦而聞名,并且非常注重細節。

Persona 3

Aaron 是一個缺乏自信的新聞專業,因此不會對基礎材料進行太深入的探索。他仍然是英語新手,所以沒有那么熟練。此外,他還有一個讓人轟動的習慣。

提取后,LLM 會從給定塊中為每個角色提取興趣點。由于多個角色可能具有類似的興趣點,因此我們使用嵌入模型來運行語義去重,從而映射出文章中不同有趣的信息片段。

多樣性的另一方面是問題類型。我們需要問抽象、比較等問題,而不僅僅是直接的“如何/什么”問題。為此,下一步是根據文章中的信息確定適用于每個興趣點的問題類型。

最后,通過 chunk-interest-question 類型的三元組,我們可以生成所有可能的問題。通過使用 personas 和問題類型引導生成的問題,開發者可以將生成的問題轉向他們的用戶會問的問題類型。

?

興趣領域示例和問題類型:

- 反托拉斯監管審查:抽象的、診斷的

- 運營協同:提取、抽象

- 創新保護:提取、抽象、診斷

- 歐盟合并監管:抽象、診斷、提取、聚合

示例問題:

- SolarPower Corporation 和 GreenTech Inc. 的合并可能會產生哪些潛在風險或缺點,這兩家公司計劃如何緩解這些風險或缺點?

- 歐盟對此次合并的審查將對協議條款產生何種影響?SolarPower 和 GreenTech 需要作出哪些讓步才能獲得批準?

- SolarPower 和 GreenTech 希望通過此次合并實現哪些戰略優勢,以及他們計劃如何整合運營以實現這些優勢?

- SolarPower Corporation 收購 GreenTech Inc. 的三大優勢是什么,它們如何關系到公司的運營和財務?

- 多少監管機構正在審查此次合并,它們在評估中涉及哪些具體問題?

- SolarPower Corporation 和 GreenTech Inc. 需要作出哪些讓步或資產剝離,以獲得歐洲委員會的合并批準,這些讓步會對公司的運營和市場地位產生何種影響?

- FTC 對于 SolarPower Corporation 收購 GreenTech Inc. 的主要關注點是什么,這個問題會對可再生能源存儲市場產生何種影響?

第 2 步:篩選問題

生成問題后,下一步是過濾和提取最有用的子集。第一步是在生成的所有問題中刪除重復項。我們需要刪除重復項,因為不同的興趣點可以利用相鄰的信息點并在重疊的問題中生成。

接下來,我們使用語言模型(LLM)作為判斷,以確定問題與基礎段落的相關性。借助這一點,我們將努力確保問題完全由段落中存在的信息負責。然后,我們將重寫所有相關問題,使其具有對話色調。最后,我們還有另一個過濾器,用于分類和過濾可能過于泛化的問題。

第 3 步:引入角色風格

在前兩個步驟中,我們創建并整理了各種問題。最后一步是將所有問題融入人物角色的寫作風格中。

使用 LLM,我們首先根據給定的角色描述制定寫作風格。然后利用這些寫作風格,對問題進行重寫。

編寫風格示例

帕德瑪的寫作風格以清晰、精確和正式的色調為特征。她寫作風格直截了當且自信,使用簡單簡潔的語言來傳達復雜的想法。她的句子結構良好,邏輯上相互關聯,反映了她的分析頭腦和對細節的關注。她避免使用情感語言、個人觀點或華麗的修詞,而是專注于以清晰客觀的方式呈現事實和論據。她的寫作沒有模糊不清和模糊,每個要點都得到證據和推理的精心支持。整體色調專業且具有權威性,得到了讀者的尊敬和關注。雖然她的作品在創意意義上可能沒有吸引力或說服力,但在公司訴訟背景下,它在傳達她的信息和實現目標方面非常有效。

阿倫的寫作缺乏深度和分析,通常略去復雜問題的表面。他的句子簡短而簡單,反映了他的英語水平有限。盡管他付出了最大的努力,語法、語法和單詞選擇方面的錯誤很常見。為了彌補記者的缺乏信心,阿倫經常采用轟動一時的、夸張或扭曲的事實來吸引更多的注意力。他的語氣猶疑和不確定性,仿佛他不太確定自己,總體阿倫的寫作風格更像是一個小報記者,而不是嚴肅的新聞工作者。

在這三步流程的最后,我們將結束于以下問題:

- 根據現有的監管框架,擬議的合并可能需要遵守哪些其他政策指令以獲得相關部門的批準?

- 相關監管機構目前正在審查SolarPower和GreenTech合并的哪些具體方面?

- 如果 GreenTech 的精英們在大型收購后研發中心仍保持獨立運作,會被解雇嗎?

這些問題的特定塊具有隱式真值標簽,因此可用于評估各種檢索工作流。如果您對細節感興趣,或想了解如何針對您的用例改進和自定義此工作流,請參閱該 Jupyter Notebook。

要點

合成數據生成是企業為其領域特定的生成式 AI 應用提供動力支持的關鍵工作流。新的 Llama 3.1 405B 模型與 NVIDIA Nemotron-4 340B 獎勵模型搭配使用時,會生成合成數據,使企業能夠構建更準確、領域特定的自定義模型。

RAG 流程對于 LLM 根據最新信息生成基礎響應至關重要,這些響應的準確性取決于流程的質量。上述合成數據生成工作流有助于評估企業的 RAG。

要開始使用 Llama 3.1 和 NVIDIA Nemotron-4 模型,請訪問 ai.nvidia.com。

?