今年年初,5G 全球連接數量接近 20 億,預計到 2028 年將達到 77 億。雖然 5G 帶來了更快的速度、更高的容量和更低的延遲,特別是在視頻和數據流量方面,但網絡運營商創造新收入的初步承諾仍然未能實現。

大多數移動應用程序現在都已路由到云端。與此同時,基于傳統設計的無線接入網(RAN)和數據包核心解決方案隨著軟件增強和更高效的硬件不斷改進。這些運行傳統語音、數據和視頻工作負載的單一用途系統并沒有顯著增加電信公司的每個用戶的平均收入。相反,這些系統主要支持連接,并被視為運營支出,從而降低了投資回報。然而,這種方法即將改變。

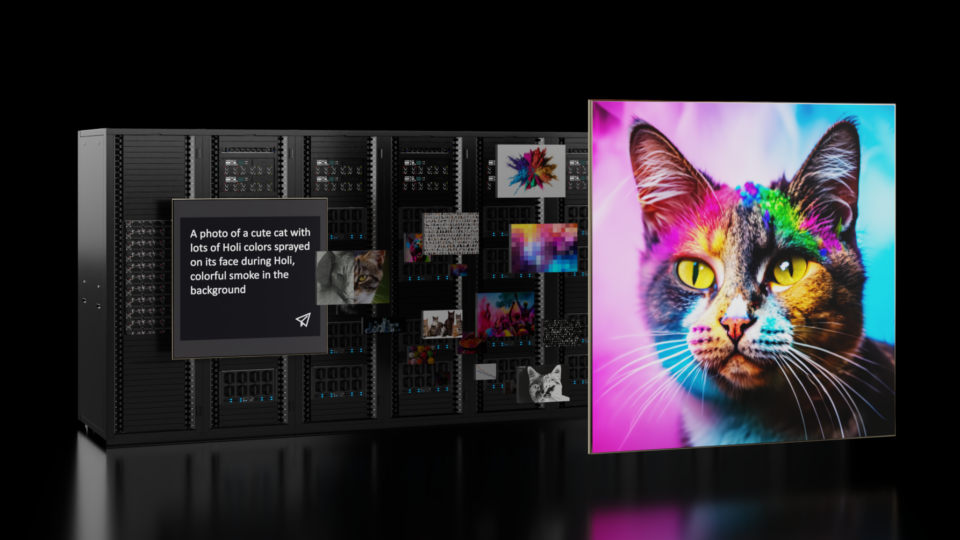

ChatGPT 和 快速大語言模型(LLM) 創新讓我們初步了解了一種需要加速計算的新型應用,這就需要不同類型的多用途網絡來優化 AI 和生成式 AI 工作負載。最初,AI 網絡部署側重于繁重的訓練工作負載,這些工作負載是集中式的,并且需要大型數據中心。早期的 LLM 推理也主要是集中式的,并與訓練工作緊密結合,從而導致從邊緣到云的更多相同的流量運動。

視覺語言模型(VLMs)和小語言模型(SLMs),以及大型語言模型(LLMs)推理效率的提高,非常適合分散在網絡中的分布式架構,從而使生成式 AI 模型更接近數據。隨著生成式 AI 向代理 AI 和多模態 AI 的演進,推理將需要與網絡端點更緊密地保持一致,因為企業需要數據定位、安全性和有保證的服務質量(QoS)。當今的電信網絡已經滿足了這些要求。

本文解釋了對 AI 原生網絡基礎設施的需求,并介紹了滿足電信網絡中 AI 工作負載需求的重要意義和機遇。

平衡 AI 推理流量與傳統工作負載

從面向大型語言模型(LLM)訓練的集中式計算架構轉向面向生成式人工智能的高度分布式推理方法,將對未來的網絡產生深遠影響。隨著小型語言模型(SLM)、視覺語言模型(VLM)和大型語言模型(LLM)推理流量的增加,網絡中數據流的請求也會增加。終端設備將演變為截取某些請求,但會受到設備端計算、內存和功耗的限制。

與傳統應用一樣,將所有網絡流量發送到云端存在問題,因為生成式 AI 模型攜帶數據以生成獨特的實時響應。將預期的消費者和企業推理請求數量與網絡上的內部模型相加會導致數據管道繁忙。

需要動態路由以提高吞吐量和延遲的多模態請求案例不斷涌現。影響數據移動的其他要求包括用戶隱私、主權和安全性,包括通過數據包核心和 UPF 允許的數據。

對于電信公司來說,這是一個絕佳的機會,因為他們的無線網絡和計算集群高度分散,并且可在許多地理位置使用。如果電信公司能夠平衡關鍵的傳統工作負載和新的 AI 推理流量,那么應用程序就會產生收入。這種方法已開始在大型語言模型(LLM)訓練中發揮作用,而生成式 AI 推理在邏輯上是電信公司應該關注的下一個盈利機會領域。

支持敏捷推理服務?

NVIDIA 和 AI 生態系統致力于打造更輕便、更敏捷的推理服務。這些服務構建為可在任何地方運行的容器,并且可以進行負載均衡、調度和以多種方式組合。可部署容器使生成式 AI 模型更接近數據,并利用 檢索增強生成 (RAG)。隨著 SLM、VLM 和多模型模型的創建以及代理工作流的普及,這一點將變得越來越重要。

網絡幾乎可以在任何地方支持 AI 容器。AI 代理和較小的模型將導致一種新型 LLM(或基于模型的路由),其中模型權重和網絡見解用于確定在何處以及如何將網絡流量負載平衡到這些模型,以防止阻塞和超額認購。

當前的網絡(尤其是邊緣網絡)并非專為這種 AI 流量的自適應路由而構建。

AI 原生網絡基礎設施?

如今,電信網絡通常對網絡的每個部分使用單一用途和硬件優化的解決方案。分布式單元(DU)和集中式單元(CU)各有一個盒,防火墻有一個盒,用戶面功能(UPF)有一個盒,以此類推。連接這些單元的網絡交換機和網絡結構在大多數情況下都未進行優化。

使用軟件定義的工作負載是解決這一問題的第一步。如果每個應用程序都可以軟件定義,那么應用程序可以在經過優化的容器中運行,并且可以在任何位置加載。

生成式 AI 格局和 LLM 的出現需要以全堆棧加速計算平臺為基礎。這種 AI 原生網絡基礎設施可以擴展,并被許多行業標準應用充分利用。理論上,相同的基礎設施可以托管任何軟件定義的應用,并根據需求動態共享,以創建未來的 AI 原生、可編程和多用途網絡,包括:

- 低功耗、高性能、高能效的 CPU(通常基于 ARM),適用于串行、虛擬化和基于租戶的應用。

- 適用于并行、向量和基于矩陣的應用程序(通常為 GPU)的高功率加速器。

- 低功耗流量加速器,用于處理中斷驅動和數據包整形用例(通常為 DPU)。

幾乎任何軟件定義的應用程序都可以通過跨 CPU、GPU 和 DPU 的強大軟件框架進行優化。

第二步是確保網絡路由和網絡結構的優化。在數據管道內部需要額外的網絡安全和優化,而不是傳統的計算架構。網絡結構必須具有可編程性,以實時適應 AI 或非 AI 工作負載,無論是支持 AI 集群中的東西向流量,還是通往防火墻或存儲設備的流量。這種網絡結構必須能夠適應 LLM 推理請求的路由和負載均衡。

許多這類工作已經在進行中,許多關鍵的獨立軟件供應商(ISV)、防火墻供應商、數據包核心提供商和其他生態系統成員正在采用軟件定義的方法來滿足電信客戶的需求。

更高的性能和新的創收機會?

AI 推理正以極快的速度發展。電信公司必須滿足 AI 流量的新需求,以及更大限度地提高計算基礎設施利用率和增加收入的需求。

通過為每項任務使用最佳工具,電信公司可以顯著提高每瓦性能,同時不損害可編程性和多用例支持。同時在同一 RAN 基礎設施上運行軟件定義的傳統工作負載和新的人工智能工作負載,可以釋放新的收入機會。

希望通過基礎設施獲利的電信公司可以采取以下任意步驟:

- 使用低功耗 CPU 和功能強大的 DPU 增強網絡結構的各個部分或全部網絡結構。這與人工智能無關,并且遵循亞太地區云服務提供商和大型電信公司成功部署的參考架構。

- 選擇邊緣位置,并為其提供支持 AI 的加速計算基礎設施。這不是一項大投資,使電信公司能夠鎖定目標客戶和使用準備好獲得 AI 驅動解決方案的用例。這些將受益于 5G/6G 就緒,并且現在可以用于 AI。

- 使用來自內部團隊和客戶用例的數據,在數據中心為內部和外部用例構建基于加速計算的集群。

總結?

隨著 LLM 驅動的應用和 AI 工作負載以前所未有的速度加速,電信公司需要重新思考管理 AI 流量的網絡。NVIDIA 正在與軟件提供商和合作伙伴合作,在整個電信生態系統中映射 AI 工作負載,遷移到軟件定義模型,并優化加速計算架構。NVIDIA 還與電信公司密切合作,分享全球進展、協作開展創新項目,并歡迎新的合作伙伴加入這一旅程。

了解 NVIDIA 企業參考架構 ,包括人工智能優化的網絡。