舊金山加利福尼亞大學的一項新研究讓癱瘓的人通過將大腦信號翻譯成計算機生成的文字來進行交流。這項研究發表在 新英格蘭醫學雜志 ,標志著為喪失說話能力的人恢復交流的一個重要里程碑。

“據我們所知,這是第一次成功地從癱瘓不能說話的人的大腦活動中直接解碼完整單詞的演示,”資深作者、加州大學舊金山分校神經外科主任瓊和桑福德·威爾( Joan and Sanford Weill )在一份新聞稿中說它顯示出通過利用大腦的自然語言機制來恢復交流的強大前景。”

一些有語音限制的人使用輔助設備——比如觸摸屏、鍵盤或語音生成計算機來進行交流。然而,每年都有成千上萬的人因為癱瘓或腦損傷而喪失了語言能力,使他們無法使用輔助技術。

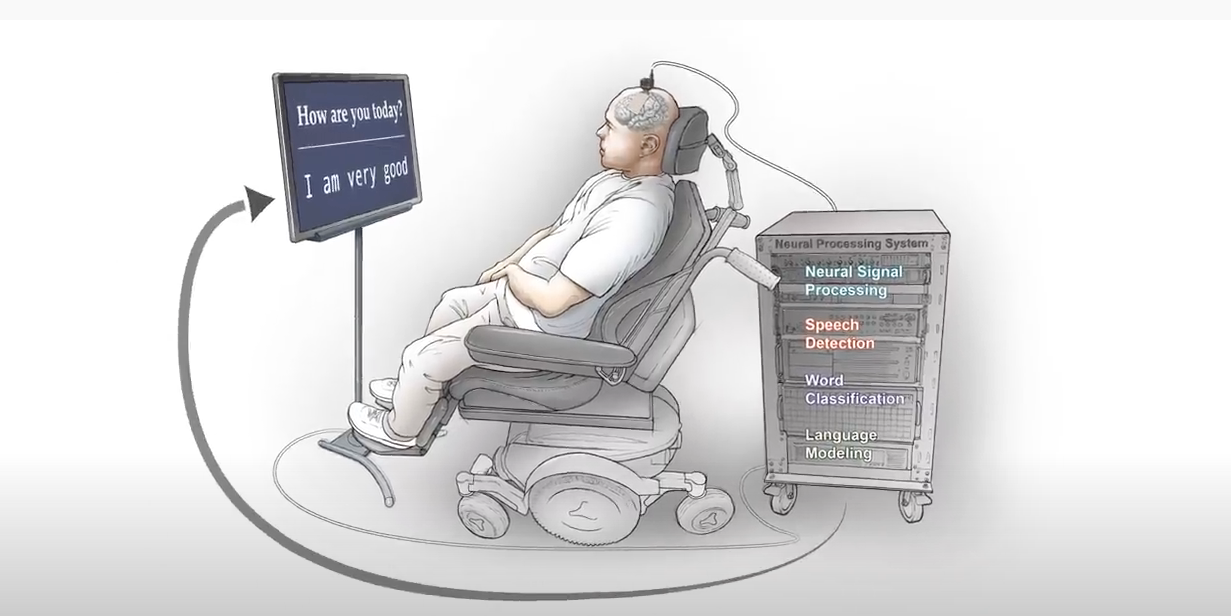

這名參與者在 2003 年失去了說話的能力,在一次車禍后因腦卒中癱瘓。研究人員不確定他的大腦是否保留了與語言有關的神經活動。為了追蹤他的大腦信號,一個由 ele CTR 節點組成的神經假體被放置在大腦的左側,跨越了幾個已知的語音處理區域。

在大約四個月的時間里,研究小組進行了 50 次培訓,參與者被要求說出單個單詞、造句或回答顯示屏上的問題。在對提示做出反應的同時, ele CTR ode 設備捕捉到了神經活動,并用定制軟件將信息傳輸到計算機。

“我們的模型需要學習復雜的大腦活動模式和預期語言之間的映射。當參與者不能說話時,這就構成了一個重大的挑戰。

為了解碼他大腦活動的反應,研究小組建立了語音檢測和單詞分類模型。使用 cuDNN – 加速 TensorFlow 框架和 32 NVIDIA V100 張量核 GPU 研究人員對模型進行了訓練、微調和評估。

“利用神經網絡是獲得我們所做的分類和檢測性能的關鍵,我們的最終產品是大量實驗的結果,”研究共同負責人肖恩·梅茨格( Sean Metzger )說因為我們的數據集是不斷發展和增長的,能夠適應我們使用的模型是至關重要的。 GPU 幫助我們進行更改、監控進度并了解數據集。”

該模型的準確率高達 93% ,中位數為 75% ,解碼速度高達每分鐘 18 次。?

“我們希望達到 1000 個單詞,最終達到所有單詞。這只是一個起點。

這項研究建立在 以前的工作 由 Chang 和他的同事開發了一種解碼和轉換大腦信號的深度學習方法。與目前的研究不同,先前研究的參與者能夠說話。

?

?