NVIDIA BioNeMo 框架已發布,現可在 NGC 上下載,使研究人員能夠在藥物研發應用中構建和部署生成式 AI、大型語言模型 (LLM) 和基礎模型。

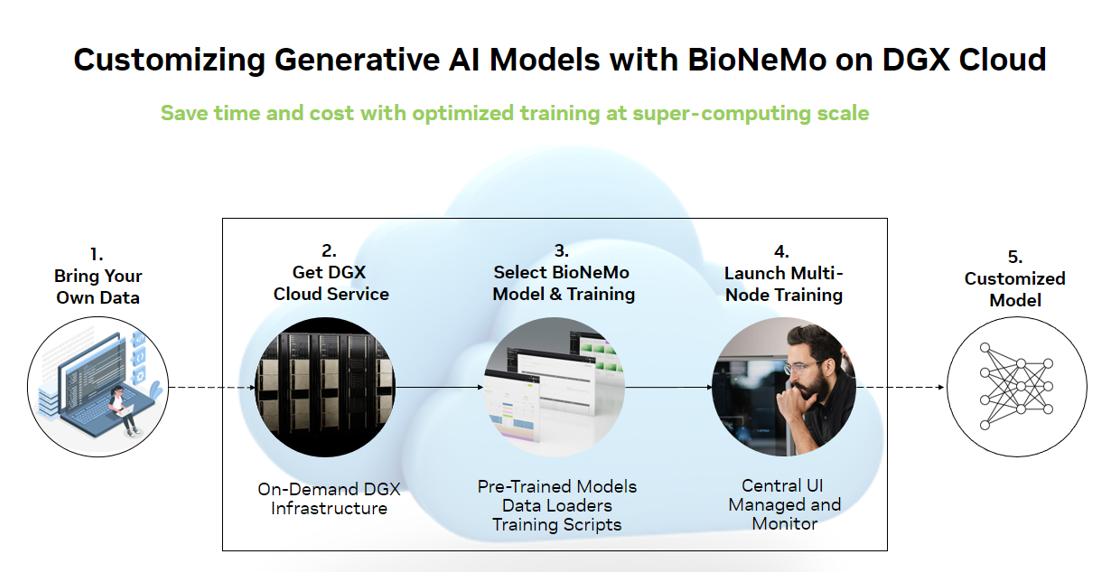

BioNeMo 平臺包括托管服務、API 端點和訓練框架,可簡化、加速和擴展用于藥物研發的生成式 AI.BioNeMo 能夠通過大規模端到端加速預訓練或微調先進的模型。它可作為 NVIDIA DGX 云上的完全托管服務和 NVIDIA Base Command 平臺,也可作為可下載的框架,用于部署本地基礎架構和各種云平臺。

這為藥物研發人員和開發者提供了一種快速輕松的方法,以便在從標識別到潛在客戶優化的整個藥物研發流程中構建和集成先進的 AI 應用。

BioNeMo 框架 v1.0 功能

- 輕松加載數據:具備自動下載器、預處理數據功能,以及對常見生物分子數據格式的支持。

- 特定于 SOTA 領域的模型:包括即開即用的架構和經過驗證的檢查點,適用于蛋白質和小分子數據的訓練。

- 優化擴展方法用于在數千個 GPU 上進行無縫加速訓練,并經過優化以最大化吞吐量并降低成本。

- 靈活的訓練工作流程:輕松地從零開始進行大規模預訓練、從可靠的檢查點進行微調,以及迅速開展下游任務的訓練。

- 驗證在環:定期監督任務訓練,用于測量模型訓練過程中嵌入的質量。實現完全自動化,并與 Weights and Biases 集成。

優化蛋白質和小分子模型的訓練

NVIDIA BioNeMo 為多個領域的生成式 AI 模型提供優化。BioNeMo 框架 v1.0 提供優化的模型架構和工具,用于訓練蛋白質和小分子 LLM:

- BioNeMo ESM1 和 ESM2

- BioNeMo MegaMolBART

- BioNeMo ProtT5

BioNeMo ESM1 和 ESM2

ESM 模型系列是一系列基于 Transformer 的蛋白質語言模型,這些模型是基于 BERT 架構構建的,并由 Meta 基礎 AI 研究蛋白質團隊 (FAIR) 開發。

通用型類似 ESM 的架構已經過優化,現已在 BioNeMo 框架中提供,并可用于蛋白質 LLM 的自定義訓練。這些模型基于蛋白質序列的海量數據集進行訓練,以了解控制蛋白質結構和功能的氨基酸之間的基礎模式和關系。

重要的是,可以通過遷移學習將經過訓練的 ESM 模型用于各種下游任務。例如,您可以使用其編碼器中的嵌入來訓練具有監督式學習目標的較小模型,以推理蛋白質的屬性。事實證明,這可以為 3D 結構預測、變異效應預測或設計等各種任務生成高度準確的模型從頭開始蛋白質。

BioNeMo 框架包含針對 ESM-2 6.5 億和 3B 參數模型的經過驗證的訓練檢查點,可實現零啟動,以創建特定領域的自定義應用程序。此外,還提供了許多下游任務示例,包括二級結構預測、亞蜂窩定位預測和熱穩定性預測。

BioNeMo MegaMolBART

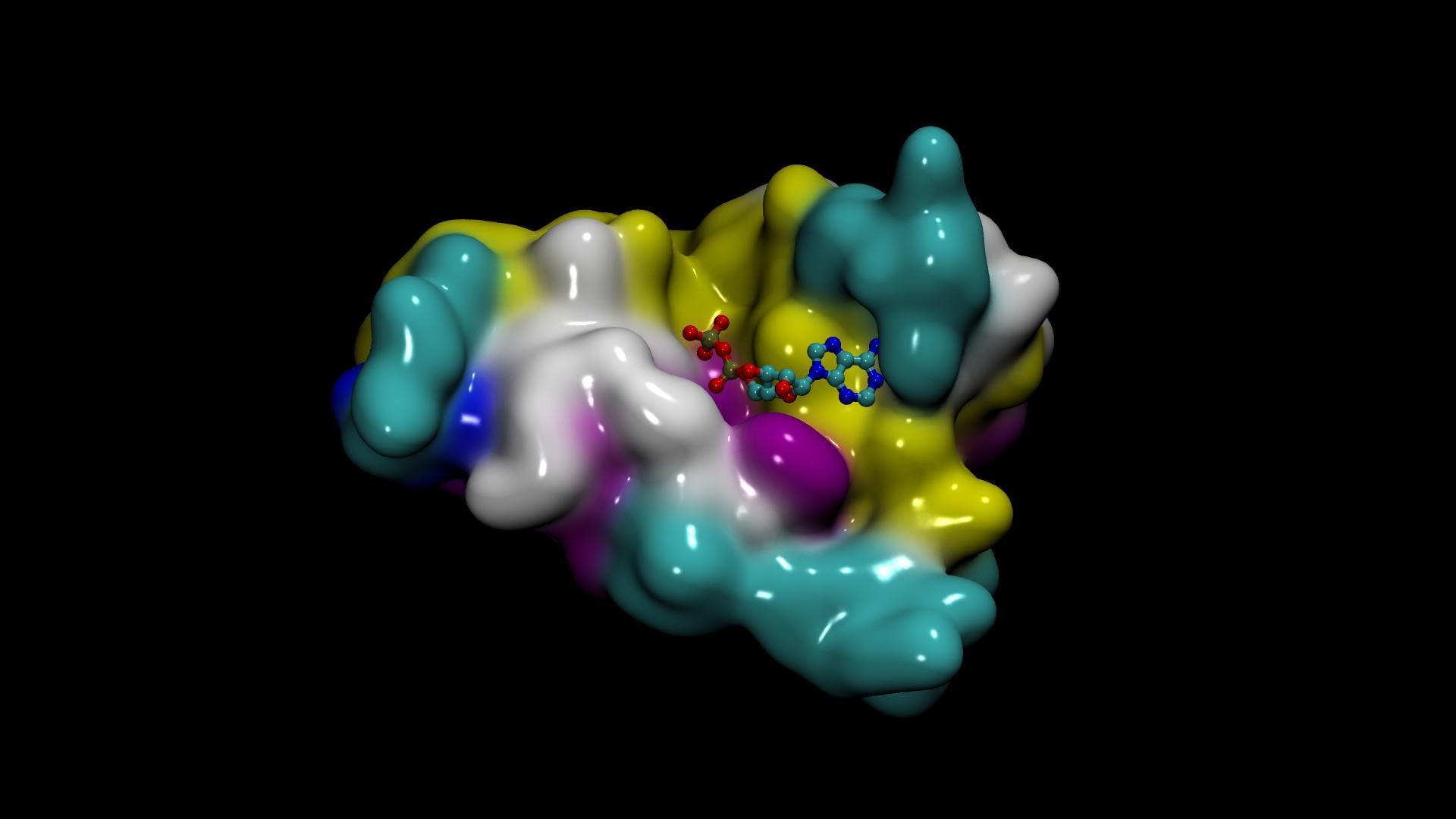

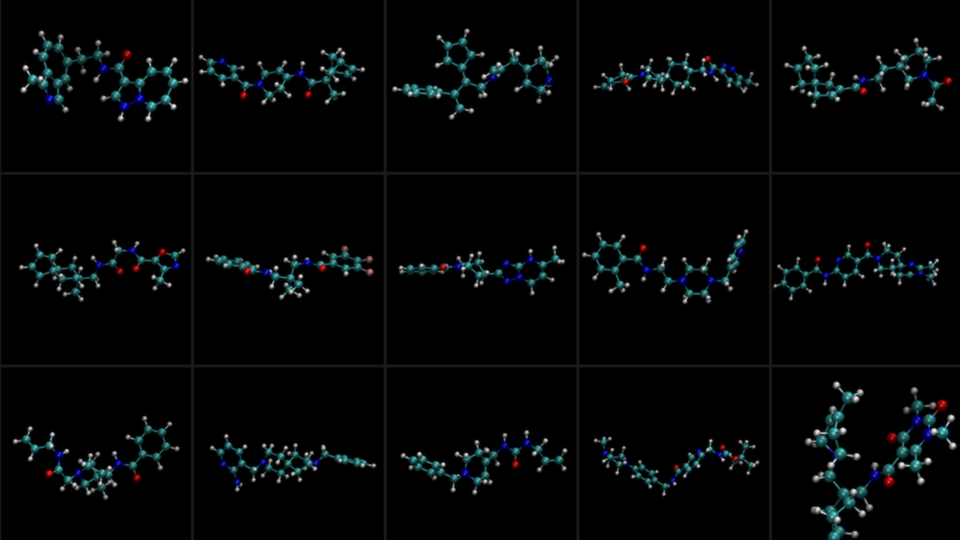

MegaMolBART 模型是使用 seq2seq Transformer BART 架構構建的生成化學模型,其靈感來自 AstraZeneca 開發的 Chemformer 模型。MegaMolBART 在小分子 SMILES 字符串的 ZINC-15 數據庫上進行訓練,總共使用 15 億個分子進行訓練。

MegaMolBART 編碼器的嵌入可用于下游預測模型,這與 ESM 或編碼器和解碼器相同,可通過對嵌入空間進行采樣來生成新分子。這意味著 MegaMolBART 可用于各種化學信息學藥物研發任務,例如反應預測、分子優化和從頭開始分子生成。

MegaMolBART 使用 BioNeMo 框架開發,該框架包括經過訓練和驗證的 4500 萬參數模型檢查點。下游任務工作流還用于預測回合成反應和物理化學屬性,例如親脂性、水解性 (ESOL) 和無水化能 (FreeSolv).

BioNeMo ProtT5

ProtT5 是一種基于編碼器/解碼器 LLM 構建的蛋白質語言模型,由 Rost Lab 使用 T5 架構開發。與 ESM 模型一樣,ProtT5 可以從其編碼器生成用于表征學習的嵌入,但也可以使用整個編碼器/解碼器架構執行序列翻譯任務。

與其他模型一樣,基礎模型可以擴展應用到下游任務,例如生成蛋白質序列。最近的一個例子是初創公司 Evozyne 創造了兩種蛋白質,這些蛋白質在醫療保健(旨在治療先天性疾病)和清潔能源(旨在消耗二氧化碳以減少全球暖化)方面具有巨大潛力。

ProtT5 模型作為 BioNeMo 框架的一部分進行了優化,包括用于 192M 參數模型的經過訓練和驗證的檢查點,以及用于二級結構預測的下游任務工作流程示例。

借助 BioNeMo 框架實現速度和規模

BioNeMo 框架使用各種技術來實現更高的吞吐量和可擴展性,包括并行性:

- 模型管道并行:模型層的分布式布局用于實現并行訓練。

- 模型張量并行:層本身被切片并分布處理。

指定精度等優化也可以帶來巨大的性能優勢,通常對模型準確性幾乎沒有影響。

BioNeMo 框架包含用于選擇和調整模型超參數的最佳實踐,能夠輕松配置其中許多選項以實現最大性能。其中一個示例是將模型張量并行化等技術應用于大小超過 10 億個參數的模型,以及用于超過 50 億個參數的模型的模型管道并行化。

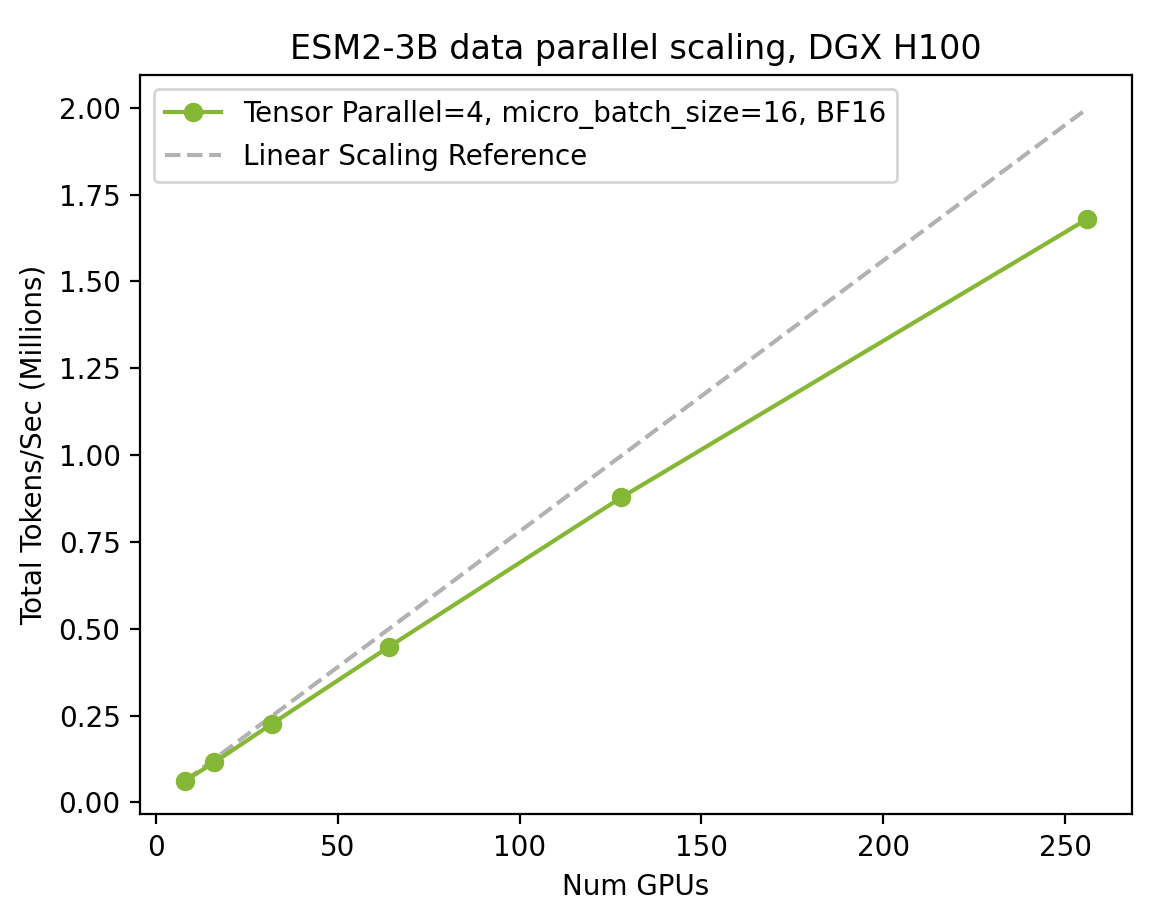

借助 BioNeMo 框架跨 H100 GPU 擴展 ESM2 訓練

圖 2 顯示了從單個 DGX 節點(8 個 H100 GPU)擴展到 32 個 DGX 節點(256 個 H100 GPU),以及由此產生的吞吐量增加(每秒令牌數)。

BioNeMo 框架和最新的 NVIDIA GPU 提供的全棧優化能夠以更快、更高效的速度訓練先進的模型。

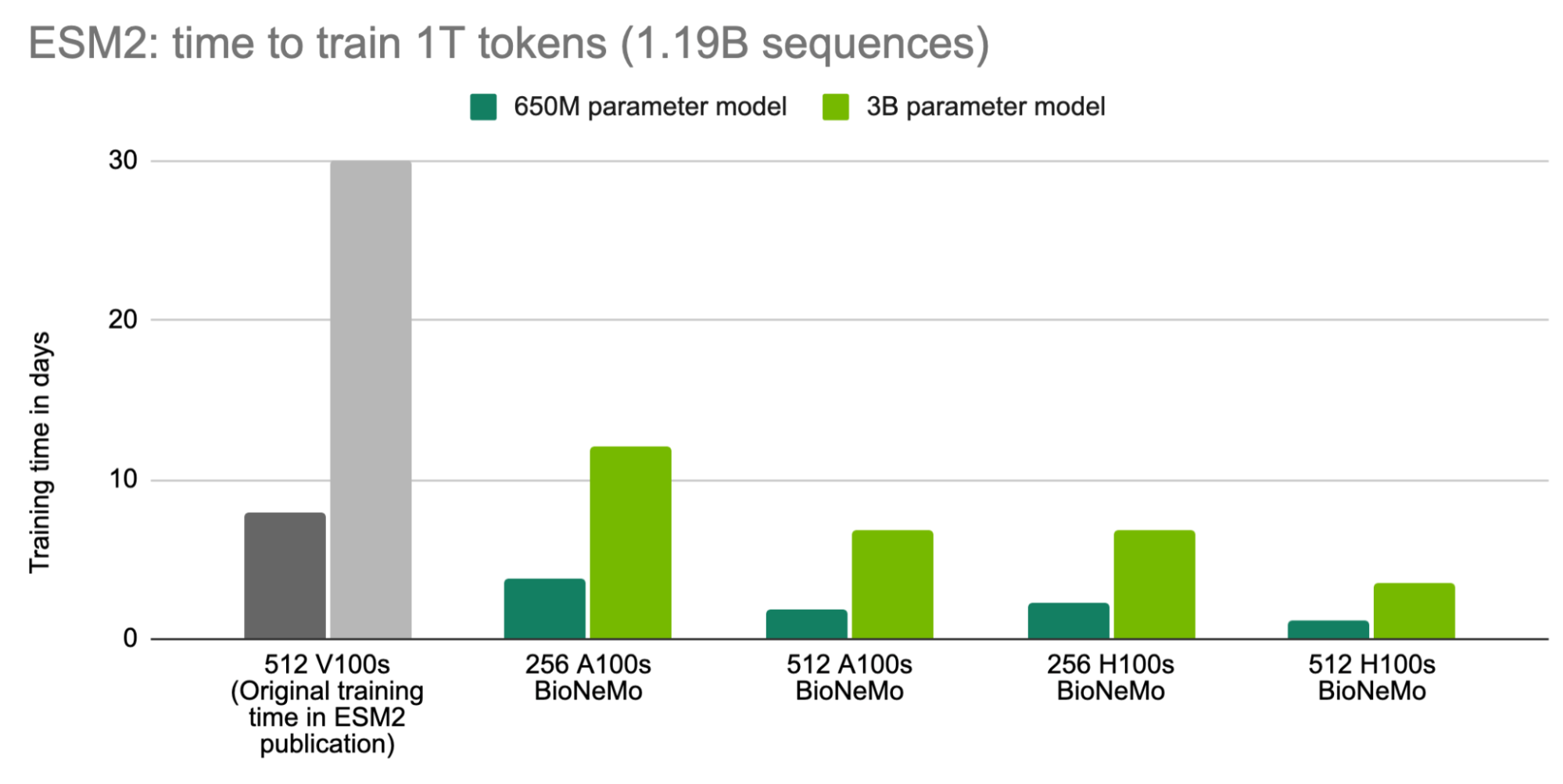

例如,ESM2 在 512 V100 GPU 上作為原始出版物的一部分進行訓練,在 8 天內完成了 6.5 億參數模型的訓練,在 30 天內完成了 3B 參數模型的訓練。現在,使用 BioNeMo 框架和 512 H100 GPU (使用 1T 令牌或 11.9 B 蛋白質序列進行訓練)訓練相同的模型,分別只需 1.2 天和 3.5 天。

這為在更短的時間內訓練更大的模型提供了機會。例如,使用 BioNeMo 框架和 512 H100 GPU,可以在 18.6 天內使用 1T 令牌訓練包含 200 億個參數的 ESM2 模型。

在更短的時間內訓練更大的 ESM2 模型

我們原始發布的模型的訓練時間以灰色顯示,供參考。使用 BioNeMo 訓練的模型是以 1T 令牌(相當于 11.9 億個蛋白質序列)進行訓練的。

BioNeMo 框架入門

BioNeMo 框架 v1.0 現已在 NGC 上推出。欲了解如何訪問、獲取最新技術文章以及觀看有關 AI 藥物研發的演講,請訪問 BioNeMo 的開始使用頁面和資源頁面。

BioNeMo 框架最佳部署在 NVIDIA DGX 云上,后者可按需提供 DGX 基礎設施,以實現卓越的吞吐量性能。這為云端企業級 AI 計算提供了全面的 AI 訓練即服務解決方案,并可直接聯系 NVIDIA AI 專家。有關更多信息,請參閱 DGX 云 頁面。

?