Megatron

2025年 3月 7日

基于 1F1B 的 MoE A2A 通信計算 Overlap

在 MoE 模型的訓練過程中,EP rank 之間的 A2A 通信在端到端時間中占據了相當大比重,對訓練效率影響很大,

3 MIN READ

2025年 1月 24日

FP8?在大模型訓練中的應用、挑戰及實踐

越來越多的技術團隊開始使用 FP8 進行大模型訓練,這主要因為 FP8 有很多技術優勢,比如在新一代的 GPU 上,

3 MIN READ

2024年 12月 10日

如何使用 FP8 加速大模型訓練

利用 FP8 技術加速 LLM 推理和訓練越來越受到關注,本文主要和大家介紹如何使用 FP8 這項新技術加速大模型的訓練。

4 MIN READ

2024年 4月 25日

NVIDIA GPU 架構下的 FP8 訓練與推理

本文聚焦 NVIDIA FP8 訓練與推理的實踐應用,該內容來源于 2023 云棲大會 NVIDIA 專場演講。 FP8 訓練利用 E5M2/

5 MIN READ

2022年 8月 3日

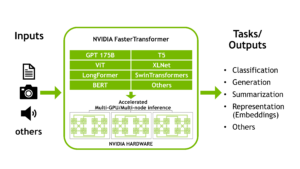

使用 FasterTransformer 和 Triton 推理服務器加速大型?Transformer?模型的推理

這是討論 NVIDIA FasterTransformer 庫的兩部分系列的第一部分,

3 MIN READ

2022年 8月 3日

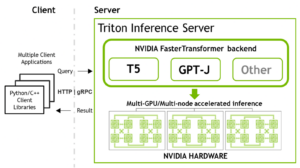

使用 FasterTransformer 和 Triton 推理服務器部署 GPT-J 和 T5

這是關于 NVIDIA 工具的兩部分系列的第二部分,這些工具允許您運行大型Transformer模型以加速推理。

5 MIN READ

2022年 7月 12日

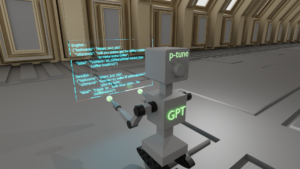

采用 P-Tuning 解決非英語下游任務

隨著對預訓練大型語言模型( LLM )權重訪問需求的增加,圍繞 LLM 共享的環境正在發生變化。最近,

3 MIN READ

2022年 5月 12日

使用 Transformers 生成合成數據:企業數據挑戰的解決方案

大數據、新算法和快速計算是使現代 AI 革命成為可能的三個主要因素。然而,數據給企業帶來了許多挑戰:數據標記困難、數據治理效率低下、

2 MIN READ

2022年 3月 9日

GTC 內幕指南:計算機視覺、 NLP 、推薦者和機器人

尋找不同的主題領域?留意我們的其他帖子! 3 月 21 日至 24 日,加入 GTC ,探索人工智能、計算機視覺、數據科學、

1 MIN READ

2021年 11月 9日

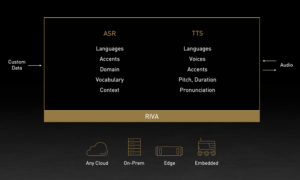

NVIDIA 發布 Riva 語音 AI 和大型企業語言建模軟件

NVIDIA 最近發布了 NVIDIA Riva 在語音人工智能方面的新突破, NVIDIA NeMo 在大規模語言建模( LLM…

1 MIN READ

2021年 10月 11日

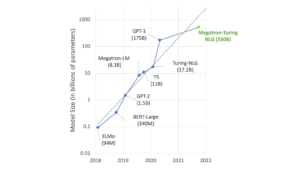

使用 DeepSpeed 和 Megatron 培訓 Megatron 圖靈 NLG 530B ,世界上最大、最強大的生成性語言模型

我們很高興地介紹由 DeepSpeed 和 Megatron 驅動的 Megatron 圖靈自然語言生成模型( MT-NLG ),

3 MIN READ