Development & Optimization

2025年 6月 25日

如何使用 NVIDIA NeMo 技能簡化復雜的 LLM 工作流程

改進 LLM 的典型方法涉及多個階段:合成數據生成 (SDG) 、通過監督式微調 (SFT) 或強化學習 (RL) 進行模型訓練以及模型評估。

4 MIN READ

2025年 6月 18日

編譯器資源管理器:CUDA 開發者必備的內核實驗室

您是否曾想過,當您編寫 GPU 核函數時,CUDA 編譯器究竟會生成什么?是否曾想與同事輕松分享精簡的 CUDA 示例,

2 MIN READ

2025年 6月 18日

NVIDIA 集合通信庫 2.26 實現性能和監控功能的提升

NVIDIA 集合通信庫 (NCCL) 可實現針對 NVIDIA GPU 和網絡優化的多 GPU 和多節點通信基元。

3 MIN READ

2025年 6月 13日

使用 FlashInfer 運行 NVIDIA 的高性能 LLM 推理內核

出色的 LLM 推理需要兩個關鍵要素:速度和開發者速度。速度是指通過使用高度優化的計算內核算法,最大限度地提高底層硬件的效率。

2 MIN READ

2025年 6月 12日

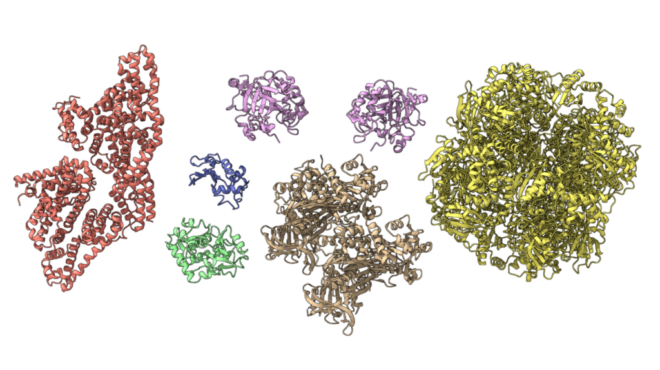

借助 MMseqs2-GPU 和 NVIDIA NIM 加速蛋白質科學序列對齊

蛋白質序列對齊 (比較蛋白質序列的相似性) 是現代生物學和醫學的基礎。它通過重建進化關系 (技術上稱為 homology…

3 MIN READ

2025年 6月 11日

隆重推出 NVIDIA DGX 云 Lepton:面向開發者的統一 AI 平臺

AI 原生應用的時代已經到來。開發者正在構建先進的代理式 AI 和物理 AI 系統,但跨地區和 GPU 提供商進行擴展仍然是一項挑戰。

2 MIN READ

2025年 6月 11日

使用開源 NVIDIA cuOpt 加速決策優化

企業每天都會做出成千上萬的決策,包括生產什么、在哪里發貨、如何分配資源。大規模優化這些決策成為一項計算挑戰。線性規劃 (LP) 、

2 MIN READ

2025年 6月 6日

NVIDIA GB200 NVL72 和 NVIDIA Dynamo 如何提升 MoE 模型的推理性能

最新一批開源大語言模型 (LLMs) 采用了 Mixture of Experts (MoE) 架構,如 DeepSeek R1、

4 MIN READ

2025年 6月 4日

借助 NVIDIA 多進程服務更大限度地提高 OpenMM 分子動力學吞吐量

分子動力學 (MD) 模擬模擬原子在一段時間內的相互作用,并且需要強大的計算能力。然而,許多模擬的系統規模很小 (約 400K 個原子) ,

3 MIN READ

2025年 6月 3日

NVIDIA Base Command Manager 為 AI 集群管理提供免費的啟動程序

隨著 AI 和高性能計算 (HPC) 工作負載變得越來越常見和復雜,系統管理員和集群管理員是確保一切平穩運行的核心。他們的工作 (構建、

1 MIN READ

2025年 5月 27日

在 NVIDIA Grace Hopper 上分析大型語言模型訓練工作流

AI 的快速發展催生了模型大小呈指數級增長的時代,特別是在大語言模型 (LLMs) 領域。這些模型憑借其變革能力,正在推動各行各業的創新。

3 MIN READ

2025年 5月 27日

在 NVIDIA Grace Hopper 上訓練大型語言模型的高級優化策略

雖然分析有助于識別效率低下的情況,但高級優化策略對于解決硬件限制和有效擴展 AI 工作負載至關重要。在本文中,我們將探討 CPU 卸載、

3 MIN READ

2025年 5月 22日

聚焦:Infleqtion 利用 Q-CHOP 和 NVIDIA CUDA-Q Dynamics 進行投資組合優化

計算是現代金融服務行業必不可少的工具。根據指導財務決策的算法的速度和準確性,利潤是成敗的。

2 MIN READ

2025年 5月 15日

使用 GPU 預測 Apache Spark 的性能

大數據分析領域正在不斷尋找加速處理和降低基礎設施成本的方法。Apache Spark 已成為用于橫向擴展分析的領先平臺,可處理 ETL、

2 MIN READ

2025年 5月 9日

CUDA C++ 編譯器更新對 ELF 可見性和鏈接影響

在下一個 CUDA 主要版本 CUDA 13.0 中,NVIDIA 將對 NVIDIA CUDA 編譯器驅動程序 (NVCC)…

4 MIN READ

2025年 5月 2日

CUDA 入門教程:更簡單的介紹 (更新版)

注意:本博文最初發布于 2017 年 1 月 25 日,但已進行編輯以反映新的更新。 本文非常簡單地介紹了 CUDA,

5 MIN READ