數據中心/云

2025年 8月 4日

NVIDIA CUDA-Q 0.12 擴展了用于開發硬件性能量子應用的工具集

NVIDIA CUDA-Q 0.12 引入了新的仿真工具,可加速研究人員開發量子應用和設計高性能量子硬件。 借助新的 API,

2 MIN READ

2025年 8月 4日

GPU 架構支持導航:面向 NVIDIA CUDA 開發者的指南

如果您最近使用 NVIDIA CUDA 編譯器 (NVCC) 開發 NVIDIA GPU 應用,您可能會遇到以下警告消息: 這究竟意味著什么,

1 MIN READ

2025年 8月 1日

通過訓練后量化優化 LLM 的性能和準確性

量化是開發者的核心工具,旨在以最小的開銷來提高推理性能。通過以可控的方式降低模型精度,無需重新訓練,該技術可顯著降低延遲、

4 MIN READ

2025年 7月 30日

使用 CI/CD 自動化網絡配置和部署

持續集成和持續交付/部署 (CI/CD) 是一套現代軟件開發實踐,用于更可靠、更頻繁地交付代碼更改。雖然 CI/CD 在軟件領域得到廣泛采用,

1 MIN READ

2025年 7月 28日

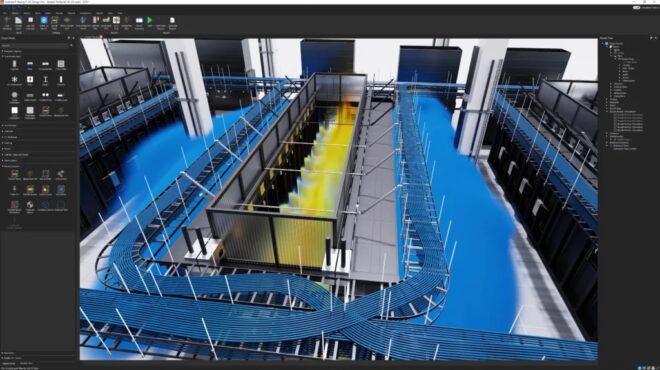

新的 GB300 NVL72 功能如何為 AI 提供穩定的動力

電網的設計目的是支持相對穩定的負載,例如照明、家用電器和以恒定功率運行的工業機器。但如今的數據中心,尤其是運行 AI 工作負載的數據中心,

2 MIN READ

2025年 7月 23日

在 Azure 上使用 Apache Spark 和 NVIDIA AI 進行無服務器分布式數據處理

將大量文本庫轉換為數字表示 (稱為嵌入) 的過程對于生成式 AI 至關重要。從語義搜索和推薦引擎到檢索增強生成 (RAG) ,

2 MIN READ

2025年 7月 22日

了解 NCCL 調優以加速 GPU 之間的通信

NVIDIA 集合通信庫 (NCCL) 對于 AI 工作負載中的快速 GPU 到 GPU 通信至關重要,可使用各種優化和調優來提升性能。但是,

3 MIN READ

2025年 7月 18日

使用 JAX 和 XLA 優化推理工作負載的低延遲通信

在生產環境中使用大語言模型 (LLM) 進行推理需要滿足嚴格的延遲限制。此過程的關鍵階段是 LLM 解碼,

2 MIN READ

2025年 7月 18日

使用 Ansible 和 Git 實現 NVIDIA Air 網絡設計自動化

NVIDIA Air 的核心是實現自動化。您可以對網絡的每個部分進行編碼和版本控制,并將其設置為自動觸發。這包括創建拓撲、

2 MIN READ

2025年 7月 15日

NVIDIA Dynamo 新增對亞馬遜云科技服務的支持,可大規模提供經濟高效的推理

亞馬遜云科技 (AWS) 開發者和解決方案架構師現在可以在基于 NVIDIA GPU 的 Amazon EC2 上使用 NVIDIA…

2 MIN READ

2025年 7月 15日

借助亞馬遜云科技上的?NVIDIA Run:ai?加速?AI?模型編排

在開發和部署高級 AI 模型時,訪問可擴展的高效 GPU 基礎設施至關重要。但是,在云原生、容器化環境中管理此基礎設施可能既復雜又昂貴。

1 MIN READ

2025年 7月 14日

NCCL 深度解析:跨數據中心通信與網絡拓撲感知

隨著 AI 訓練規模的擴大,單個數據中心 (DC) 不足以提供所需的計算能力。

2 MIN READ

2025年 7月 14日

借助 NCCL 2.27 實現快速推理和彈性訓練

隨著 AI 工作負載的擴展,快速可靠的 GPU 通信變得至關重要,這不僅適用于訓練,而且越來越適用于大規模推理。

3 MIN READ

2025年 7月 10日

InfiniBand 多層安全保護數據中心和 AI 工作負載

在當今數據驅動的世界中,安全性不僅僅是一項功能,更是基礎。隨著 AI、HPC 和超大規模云計算的指數級增長,

1 MIN READ

2025年 7月 7日

LLM 推理基準測試:使用 TensorRT-LLM 進行性能調優

這是大語言模型延遲 – 吞吐量基準測試系列的第三篇博文,旨在指導開發者如何使用 TensorRT-LLM 對 LLM 推理進行基準測試。

3 MIN READ

2025年 7月 7日

使用 DPU 加速的 Kubernetes 服務代理增強 AI 工廠

隨著 AI 借助代理式 AI 向規劃、研究和推理發展,工作流變得越來越復雜。為了高效部署代理式 AI 應用,AI 云需要軟件定義、

2 MIN READ