?

去年 11 月,AWS 在 Amazon SageMaker 中集成了開源推理服務軟件 NVIDIA Triton Inference Server。機器學習 (ML) 團隊可以使用 Amazon SageMaker 作為一項完全托管的服務來大規模構建和部署 ML 模型。

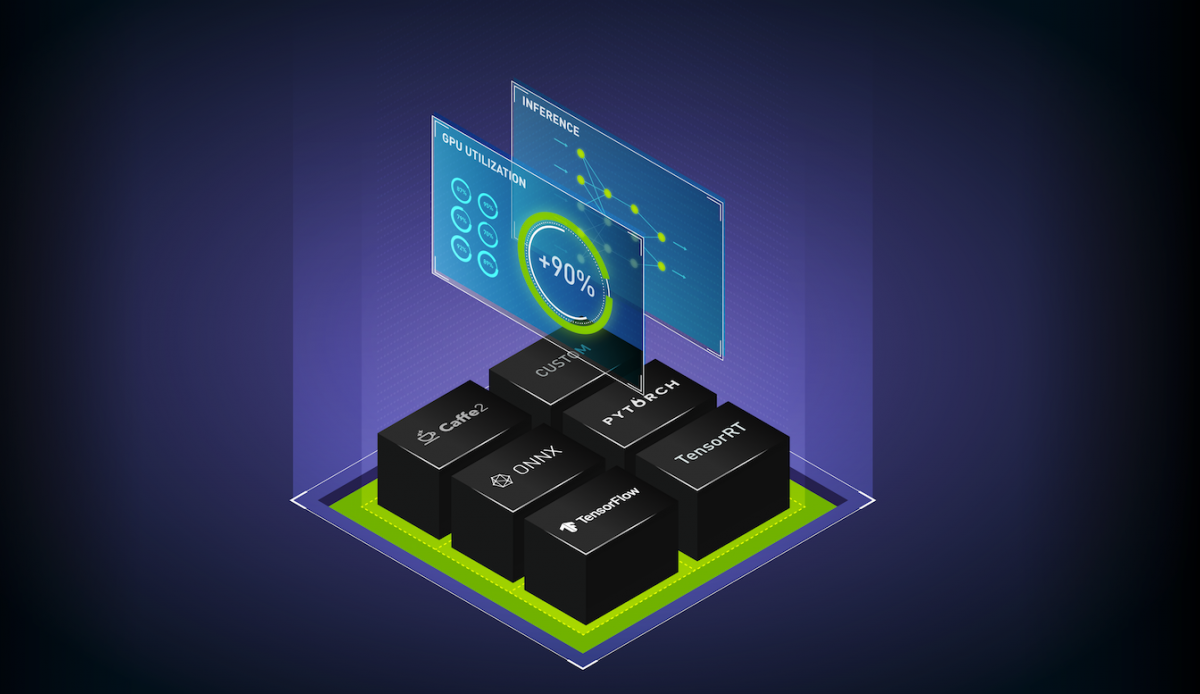

通過這種集成,數據科學家和 ML 工程師可以輕松地使用 NVIDIA Triton 多框架、高性能推理,與 Amazon SageMaker 完全管理的模型部署一起使用。

多模型端點在 GPU 上以低成本實現更高的性能

今天, AWS 在 Amazon 上宣布了 Amazon GPU 多模型端點( MME )。 MME 提供在 GPU 上運行多個深度學習或 ML 模型的能力,同時使用 Triton 推理服務器。有關詳細信息,請參見 Run Multiple Deep Learning Models on GPU with Amazon SageMaker Multi-Model Endpoints 。

MME 支持跨多個模型共享端點后的 GPU 實例,并基于傳入流量動態加載和卸載模型。有了這一點,您可以輕松實現最佳性價比。

GPU 上 MME 的縮放推斷

為了利用 GPU 的巨大處理能力, MME 使用 Triton 推理服務器并發模型執行功能,該功能在同一 AWS GPU 實例上并行運行多個模型。該功能通過運行許多模型來幫助 ML 團隊擴展 AI ,這些模型服務于許多推理請求并具有嚴格的延遲要求。您的 ML 團隊將看到 GPU 利用率和推理成本的提高。

在 Amazon SageMaker 可用的所有地區都可以獲得支持, Triton 推理服務器容器無需額外費用。

- Run Multiple Deep Learning Models on GPU with Amazon SageMaker Multi-Modal-Endpoints

- Amazon SageMaker Cost-Effectively Hosts 1000s of GPU Multi-Model Endpoints

立即在 GPU 上使用 Amazon SageMaker multi-model endpoint 。

?

?

加入 NVIDIA Triton 和 NVIDIA TensorRT 社區?,了解最新產品。

?