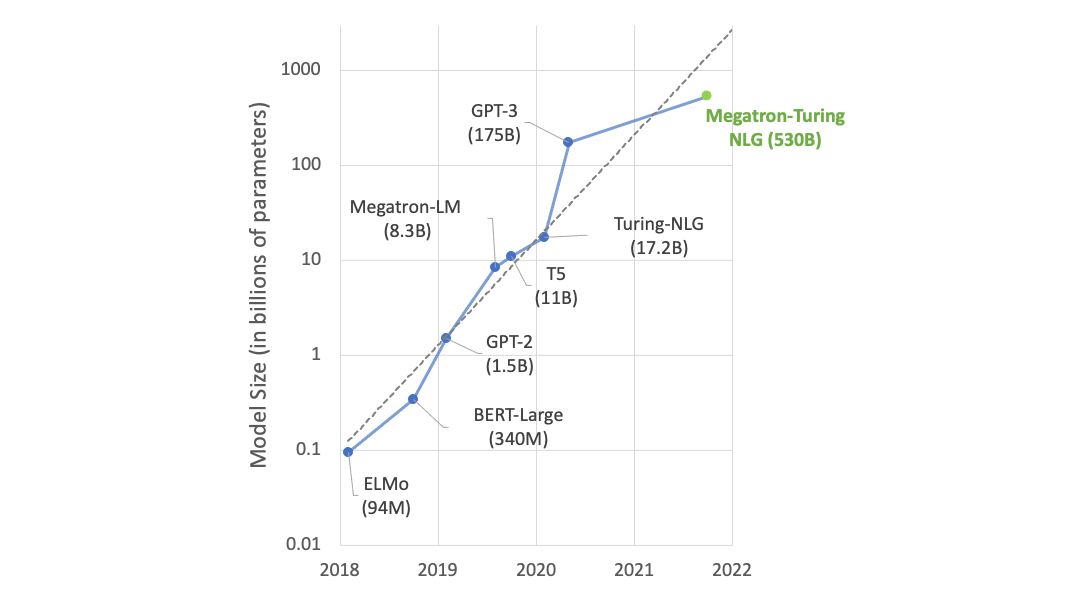

OpenAI 研究人員最近發布了 研究報告?描述 GPT-3 ,一個由 1750 億個參數組成的最先進的語言模型。

相比之下,以前的版本 GPT-2 由 15 億個參數組成。微軟本月早些時候發布了最大的基于 Transformer 的語言模型,該模型由 170 億個參數組成。

“ GPT-3 在許多自然語言處理數據集上取得了很好的性能,包括翻譯、問答和完形填空任務,以及一些需要動態推理或領域調整的任務,如解譯單詞、在句子中使用新單詞或執行 3 位數算術,”研究人員在其研究報告中表示 紙張 “我們發現, GPT-3 可以生成新聞文章樣本,人類評估人員難以將其與人類撰寫的文章區分開來。”

自然語言處理任務從生成新聞文章、語言翻譯到回答標準化測試問題。

該組織表示:“每個模型的精確架構參數是基于計算效率和 GPU 模型布局中的負載平衡來選擇的。” 規定的 “所有模型都接受過訓練 NVIDIA V100 GPU 作為 Microsoft 提供的高帶寬集群的一部分。”

OpenAI 在 cuDNN 加速的 PyTorch 深度學習框架上訓練他們所有的 AI 模型。

本月早些時候,微軟和 OpenAI 宣布了一款專為該組織設計的新的 GPU 加速超級計算機。

“為 OpenAI 開發的超級計算機是一個單一系統,每個 GPU 服務器擁有超過 285000 個 GPU 核、 10000 個 GPU 和每秒 400 千兆位的網絡連接,”這些公司在 博客?里的一份聲明中表示?.

在性能方面,新的 GPT-3 模型在 SuperGLUE 基準上取得了接近最先進的結果,去年引入該基準測試推理和其他高級 NLP 任務。在包括 COPA 和 ReCoRD 在內的其他基準測試中,該模型與上下文分析( WIC )和一組中學和高中考試題 RACE 相比都有不足。

該組織說:“盡管存在許多局限性和弱點,但這些結果表明,非常大的語言模型可能是開發適應性強的通用語言系統的一個重要因素。”。

?