生成式 AI 模型具有多種用途,例如幫助編寫計算機代碼、創作故事、作曲、生成圖像、制作視頻等。而且,隨著這些模型的大小不斷增加,并且使用更多數據進行訓練,它們將產生更高質量的輸出。

構建和部署這些更智能的模型需要非常大的計算量,需要許多高性能處理器并行工作,并由高效、通用的軟件進行編排。

例如,Meta 宣布訓練其最新的 Llama 3 系列中的?大語言模型(LLMs),使用搭載 24,576 個 NVIDIA H100 Tensor Core GPUs 的人工智能集群。模型越大,Llama 3 70B 就需要總計6.4 million H100 GPU-hours進行訓練。

預訓練 LLM 后,可以通過各種技術包括模型微調,以提高特定任務的準確性。隨著企業開始在各種應用中采用 LLM,LLM 微調正迅速成為核心行業工作負載。

AI 訓練是一項全棧挑戰,提供出色的端到端訓練性能需要強大的處理器、快速內存、高帶寬和低延遲網絡以及優化軟件的組合。

MLPerf Training已經成為衡量和評估端到端 AI 訓練性能的行業標準基準。由 MLCommons 聯盟開發的 MLPerf Training 工作負載經常更新,以反映最新的 AI 用例。在每一輪提交中,結果都經過嚴格的同行評審過程,以確保其在發布前的完整性和可靠性。

在 MLPerf Training v4.0 中,NVIDIA 創下了新的生成式 AI 訓練性能記錄,并繼續為各種工作負載提供更高的性能。此性能使用完整的 NVIDIA 軟件和硬件堆棧提供:

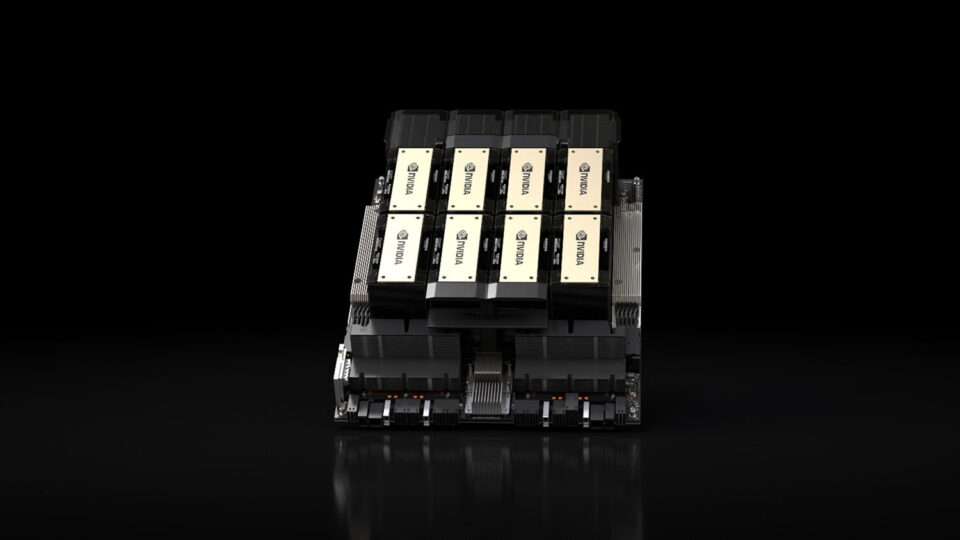

- NVIDIA Hopper GPU

- 最新的第四代 NVLink 互聯技術與最新的第三代 NVSwitch 芯片相結合

- NVIDIA Quantum-2 InfiniBand 網絡

- 經過優化的多功能 NVIDIA 軟件堆棧:

自上一輪 MLPerf 訓練以來,每個組件都進行了進一步優化,以繼續為用戶提供更高的性能和價值。本文將詳細介紹這些出色的結果。

MLPerf 訓練 v4.0 更新

本輪 MLPerf 測試新增兩項測試,以反映熱門行業工作負載。

第一種方法是測量使用熱門的低級適應(LoRA) 技術。LLM 微調使企業能夠使用其專有數據自定義 LLM,從而提高特定用例的響應質量。

第二個新測試的重點是圖形神經網絡(GNN) 訓練,基于 RGAT (關系圖注意力網絡) 的實現。GNN 正在應用于許多領域,包括藥物研發、欺詐檢測和推薦系統。

最新的 MLPerf Training v4.0 測試套件具有以下工作負載:

- LLM 預訓練 (GPT-3 175B)

- LLM 微調 (使用 LoRA 的 Lama 2 70B)

- 圖形神經網絡 (GNN)

- 文本轉圖像 (Stable Diffusion v2)

- 推薦系統 (DLRM-dcnv2)

- 自然語言處理 (BERT-Large)

- 圖像分類 (ResNet-50)

- 輕量級物體檢測 (RetinaNet)

- 生物醫學圖像分割 (3D U-Net)

由于 AI 是一個多樣化且快速發展的領域,并且新的模型和應用程序不斷被發明,因此 MLPerf 等行業基準必須涵蓋廣泛的用例,并與行業趨勢同步發展。

NVIDIA 創造了新的 LLM 預訓練性能和規模記錄

MLPerf 包含基于 175B 參數語言模型(LLM)GPT-3 的預訓練基準測試,這是一個由 OpenAI 開發的 175B 參數 LLM 工作負載,要求極高,對大規模 LLM 訓練性能的良好測試,它強調加速計算平臺的計算、網絡和軟件效率。

去年,在 MLPerf Training v3.0 中引入 GPT3-175B LLM 基準測試時,NVIDIA 首次提交了相關結果。我們使用 3584 H100 GPU 實現了 10.9 分鐘的訓練時間,這反映了當時的性能和規模記錄。

在這輪 MLPerf 訓練中,NVIDIA 將其提交規模擴大了三倍多,達到 11,616 個 H100 GPUs,并將性能提高了三倍多,達到 3.4 分鐘,實現了近線性性能擴展。這些結果建立在 NVIDIA 上一輪創下的先前記錄之上,其中 10,752 個 H100 GPUs 提供的訓練時間僅為 3.9 分鐘。

MLPerf 訓練 v3.1 和 v4.0 結果來自www.mlperf.org,發布于 2024 年 6 月 12 日,來自以下條目:NVIDIA 3.0-2069、NVIDIA 4.0-0059。NVIDIA A100 結果以 512 A100 未經 MLCommons 驗證。MLPerf 名稱和徽標均為 MLCommons Association 在美國和其他國家/地區的商標。所有權利保留。未經授權嚴禁使用。有關更多信息,請參閱 www.mlcommons.org。

NVIDIA 本輪提交的出色結果反映了提交規模的擴大,以及進一步提升大規模交付性能的重大軟件改進。

一個值得注意的例子是在 NVIDIA 語言模型(LLM)提交中首次使用 CUDA Graphs。隨著訓練擴展到數千個 GPUs,CPU 開銷變得更加明顯。使用 CUDA Graphs 可以通過單個 CPU 操作啟動多個 GPU 操作,這也有助于最大限度地提供性能。

在使用 512 個 GPU 時,H100 的性能僅在一年內就提升了 27%,在一小時內完成了工作負載,每個 GPU 的利用率現已達到 904 TFLOP/s。

MLPerf 訓練 v3.1 和 v4.0 結果來自www.mlperf.org,發布于 2024 年 6 月 12 日,來自以下條目:NVIDIA 3.0-2069、NVIDIA 4.0-0059。搭載 512 A100 的 NVIDIA A100 結果未經 MLCommons 驗證。MLPerf 名稱和徽標均為 MLCommons Association 在美國和其他國家地區的商標。所有權利保留。未經授權不得使用。有關更多信息,請參閱 www.mlcommons.org。

NVIDIA 軟件堆棧的多項改進實現了這一非凡的成果:

- 經過優化的 FP8 內核

- 全新的 FP8 感知型分布式優化器

- cuDNN 中經過優化的 FlashAttention 實現

- 更有效地重疊執行數學運算和 GPU 到 GPU 的通信運算

- H100 GPU 內的智能功率分配可更大限度地提高 Tensor Core 吞吐量

深入了解最后一項優化,大型語言模型(LLM)訓練的一個顯著特點是其高計算強度。特別是對于較小規模的 LLM 運行,與 GPU 到 GPU 通信相關的操作相比,math operations 可以彌補執行每個訓練步驟所需的大部分時間。這導致高 Tensor Core 利用率和可以結果在 scenarios 中 Tensor Core 吞吐量受到 GPU 可用功率的限制。

在包含 512 個 H100 GPUs 的系統中,我們通過將功率從每個 H100 GPU 上的 L2 緩存內存重定向到流式多處理器 (SM)(其中包含 NVIDIA Hopper 第四代 Tensor Cores 等單元)來提高端到端性能。這是通過使用由 NVIDIA Management Libraries (NVML) 管理的 boost 滑塊設置比率來完成的。

這使得 GPU 在相同功率預算下的工作頻率更高,端到端性能提升了 4%。可以通過命令設置 boost 滑塊nvidia-smi boost-slider –vboost 。有關此命令的更多信息(包括如何獲取所有可能值),請運行 nvidia-smi boost-slider –vboost –help。

通過使用相同的 GPU 提高性能,您可以在更短的時間內以更低的成本訓練具有類似計算要求的模型,或者在類似的時間內以類似的成本訓練計算更密集的模型。

NVIDIA 實現了更高的 LLM 微調性能

最新版本的 MLPerf 訓練包括微調測試,該測試適用于LoRA提交到 Llama 2 由 Meta 開發的 70B 模型。LoRA 是一種參數高效微調的熱門形式,在這篇博文。

NVIDIA 平臺在這項新測試中表現出色,可提供超快的單臺服務器性能以及遠超單臺 GPU 服務器的可擴展性。

搭載 8 個 H100 GPUs 的單個 DGX H100 系統提供了出色的性能,僅用了 28 分鐘就完成了測試。NVIDIA H200 Tensor Core GPU 使用 141 GB 的 HBM3e 內存升級了 NVIDIA Hopper 架構,將速度提高了 14%,將單節點訓練時間縮短至 24.7 分鐘。

NVIDIA 在本輪提交的作品中還展示了使用多達 1024 個 H100 GPU 對 LLM 進行微調的能力,在短短 1.5 分鐘內就取得了出色的成績,創下了性能和規模記錄。

為高效擴展至 1024 H100 GPU,NVIDIA 提交的 LLM 微調基準測試利用了 NVIDIA NeMo 框架中提供的上下文并行功能。如需詳細了解上下文并行以及使用 NeMo 框架時如何利用它,請參閱此頁面。

在本輪 NVIDIA LLM 微調提交中,我們使用了通過 cuDNN 提供的自注意力 FP8 實現。這在 8-GPU 規模下將性能提高了 15%.有關更多信息,請參閱使用 NVIDIA cuDNN 9 加速 Transformer。

這些出色的結果補充了監督式微調 (SFT) 和人工反饋強化學習 (RLHF) 的出色性能在 NVIDIA Hopper GPU 上演示去年年底。

與 LoRA 等參數高效的方法相比,這些 fine-tuning 技術可以提供更高的準確性,但會以更高的 compute intensity 為代價。NVIDIA NeMo 框架支持多種 model customization 技術。

NVIDIA 提高文本轉圖像生成式 AI 訓練的標準

生成式 AI 正在改變視覺設計,并應用于營銷和廣告、媒體和娛樂、產品設計和原型設計以及建筑可視化等廣泛的用例。

為表示視覺生成式 AI,MLPerf Training v4.0 包含基于 Stable Diffusion v2 的文本轉圖像基準測試。

基于 NVIDIA 在上一輪提交中創下的記錄,NVIDIA 在本輪提交中通過大量軟件增強功能,在相同提交規模下將性能提升高達 80%:

- 使用全迭代 CUDA 圖

- 使用分布式優化器用于穩定擴散

- 優化 cuDNN 和 cuBLAS 啟發式算法,實現穩定擴散

- … … 以及更多內容

MLPerf 訓練 v3.1 和 v4.0 結果檢索自www.mlperf.org。于 2024 年 6 月 12 日發布,來自以下條目:NVIDIA 3.1-2050、NVIDIA 4.0-0053。MLPerf 名稱和 logo 均為 MLCommons Association 在美國和其他國家地區的商標。保留所有權利。嚴禁未經授權使用。有關更多信息,請參閱 www.mlcommons.org

NVIDIA 加速圖形神經網絡訓練

Graph Neural Networks(GNNs) 應用于多種應用,包括社會網絡分析、藥物發現、欺詐檢測、零售中的推薦系統,甚至是分子化學。在 MLPerf 中添加 GNN 基準測試擴大了工作負載覆蓋范圍,以涵蓋這一重要的神經網絡類別。

NVIDIA 使用 8 個、64 個和 512 個 H100 GPU 提交了結果,將新的基準時間設置為在大規模配置中訓練僅 1.1 分鐘的記錄。

NVIDIA 還使用 8 個 H200 Tensor Core GPU 提交了 8 個 GPU 結果,每個 GPU 均配備 141 GB 的 HBM3e,與同等規模的 H100 提交結果相比,性能提升 47%。

要點

NVIDIA 平臺繼續為生成式 AI 和更傳統的 AI 工作負載等各種 AI 工作負載提供出色的性能和通用性。

NVIDIA 平臺正在飛速發展。通過繼續優化 NVIDIA 軟件堆棧,客戶可以享受更高的每個 GPU 性能,從而降低訓練成本,并且能夠高效擴展到更多 GPU,以訓練要求更苛刻的模型。

NVIDIA 平臺通過在整個堆棧(包括新芯片和系統)中的創新不斷提供更高的性能。NVIDIA Blackwell該平臺在 GTC 2024 上發布,旨在普及 trillion-parameter AI,NVIDIA GB200 NVL72與相同數量的 NVIDIA Hopper GPUs 相比,實時 trillion-parameter 推理速度提升高達 30 倍,trillion-parameter 訓練速度提升高達 4 倍。

?

?