每年 8 月,成千上萬的安全專業人員都會參加最前沿的安全會議 Black Hat USA 和 DEF CON。這一年,NVIDIA AI 安全專家參加了這些活動,分享我們的工作,并向社區其他成員學習。

本文概述了這些貢獻,包括關于快速發展的 AI 環境的主題演講、對抗性機器學習訓練、關于大型語言模型(LLM)安全性的演講等。這項工作有助于為安全社區提供必要的知識,以便他們以安全為理念有效部署 AI 系統。

NVIDIA 亮相 Black Hat USA 2024?

Black Hat 是一項國際公認的網絡安全活動,提供相關的技術和信息安全研究。本年,圍繞生成式 AI 工具在安全生態系統中的應用可能性以及 AI 部署本身的安全性,討論聲不斷增長。

在 AI 峰會主題演講中,NVIDIA 網絡安全 AI 總監 Bartley Richardson 與 WWT 首席執行官 Jim Kavanaugh 共同分享了對迅速發展的 AI 格局的見解,特別是 AI 和自動化如何改變應對當今網絡挑戰的方式。在其他會議中,來自 NVIDIA 及其合作伙伴的專家討論了 AI 如何變革安全態勢,以及圍繞 AI 系統的安全技術。

許多 Black Hat 簡報都表達了一種共同的觀點:部署 AI 工具和系統本質上需要一種經過測量的安全方法,而實施有效的信任邊界和訪問控制仍然非常重要。

在一場關于 AI 安全的小組討論中,NVIDIA AI 和法律道德高級總監 Nikki Pope 與 Microsoft 和 Google 的從業者一起討論了 AI 安全的復雜格局、常見的神話和陷阱,以及負責部署安全負責的 AI 的任何人的責任。NVIDIA 軟件產品安全副總裁 Daniel Rohrer 在 Trend Micro 主持的會議上分享了 NVIDIA 對保護 AI 數據中心帶來的獨特挑戰的觀點。

NVIDIA 亮相 DEF CON 32?

DEF CON 是全球規模最大的黑客大會,在數十個村莊中,人們在諸如網絡數據、社會工程、汽車和衛星等重點場景中討論安全問題,并展開實時黑客競賽。許多 NVIDIA 研究人員都支持 DEF CON AI 村,在過去兩年中,該村莊舉辦了熱門的實時 大語言模型(LLM) 紅隊活動。

今年,AI 仍然是 AI 村 和 AI 網絡挑戰賽 (AIxCC) 的中心主題。AI 村再次舉辦了生成式紅隊挑戰賽,參賽者攻擊了 LLM,從而實時改進了模型的安全護欄和模型卡。Nikki Pope 發表了主題演講,強調了算法的公平性和安全性在 AI 系統中的關鍵作用。

在由美國國防高級研究計劃局(DARPA)主辦的 AIxCC 大會上,紅藍兩支團隊齊聚一堂,共同構建自主智能體,掃描代碼庫以識別漏洞并實施漏洞攻擊。該挑戰建立在這樣一個前提之上:安全漏洞比人們能夠識別的漏洞多,而且該領域中的 AI 賦能工具可以繼續補充和加速安全研究。

NVIDIA AI Red Team 將我們自己的專業知識引入這些重要活動,通過培訓、AI 安全講座和開源工具演示實驗室與社區分享我們的知識。

對抗性機器學習訓練?

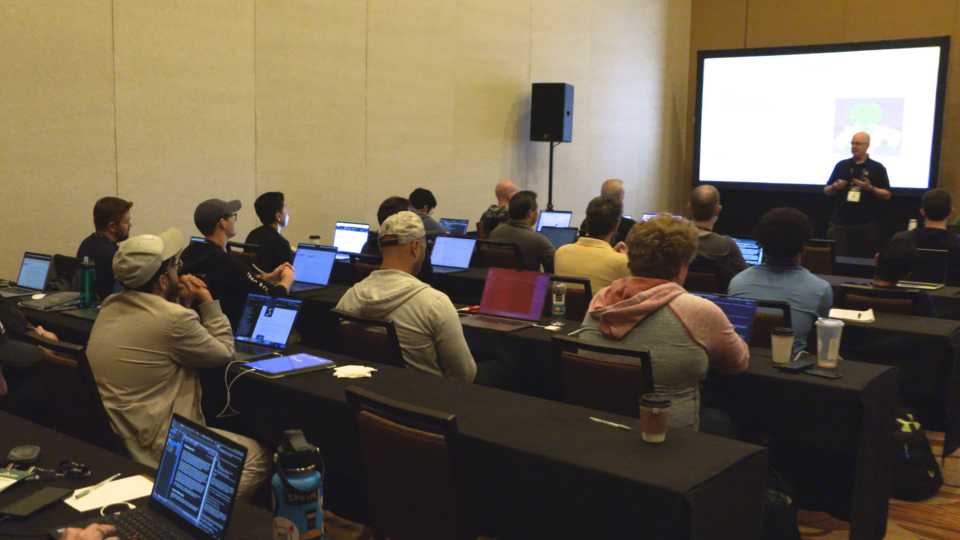

今年,NVIDIA 和 Dreadnode 在 Black Hat 舉辦了為期兩天的機器學習(ML)培訓。培訓內容涵蓋了針對 ML 模型評估安全風險的技術,以及特定攻擊的實施和執行。

學員在前往自主實驗室練習執行這些攻擊之前,會收到有關機器學習(ML)模型基礎以及針對 ML 模型的攻擊的指導。主題分為以下幾個部分:

- 簡介: 學習 PyTorch 和機器學習模型的基礎知識

- 規避: 精心制作特定的輸入,旨在欺騙模型做出錯誤的預測或分類。

- 提取: 利用對模型輸出的訪問權限,對模型的基礎參數和架構進行反向工程。

- 評估: 了解用于執行攻擊的工具和框架,以及評估模型安全性的標準化方法。

- 反演: 利用模型端點重建或推理潛在的敏感輸入/訓練數據

- 中毒: 向訓練數據集注入惡意輸入,以破壞模型的學習過程。

- LLMs: 了解提示注入,以及前面提到的對 LLMs 的攻擊次數

這些實用實驗室幫助學生獲得了執行攻擊的經驗,包括制作導致對卷積神經網絡進行錯誤分類的圖像、進行成員推理攻擊以提取模型訓練數據、在測試時毒害模型訓練數據以生成錯誤分類、針對大型語言模型(LLMs)進行提示注入等。

參加課程的學員包括數據科學家、安全工程師和首席信息安全官(CISO)。他們在離開時不僅掌握了有關機器學習(ML)和攻擊機器學習系統的基本知識,而且具備了在組織內應用對抗思維方式的框架。這些都是制定有效防御策略的關鍵要素。

查看此課程的自學版本: 探索對抗機器學習 (可通過 NVIDIA 深度學習研究所獲取)。

專注于 LLM 安全?

NVIDIA 首席安全架構師 Rich Harang 向熱情十足的 Black Hat 觀眾發表了他的演講《 實用 LLM 安全:一年來在戰壕中的收獲 》。演講的重點是在熟悉的應用程序安全框架中加強 LLM 安全,并讓觀眾基本了解圍繞 LLM 應用程序的完整威脅拓撲。

本次講座聚焦于 檢索增強生成(RAG) LLM 架構產生的安全問題。隨著許多企業在其環境中采用 LLM 應用,RAG 系統會在每次查詢時從文檔存儲中檢索數據,從而為模型提供最新的數據和上下文。

雖然 RAG 系統可以幫助 LLMs 保持更新,而無需不斷重新訓練,但它們也顯著擴展了整個架構的攻擊面。如果沒有對 RAG 數據存儲的細粒度訪問控制,第三方或攻擊者控制的數據就有可能進入 RAG 數據,從而控制模型的輸出。

整體信息很簡單:如果您的模型可以看到數據,有人就可以讓模型輸出該數據。與會者最終帶回他們的組織的三個核心要點是:

- 識別和分析信任和安全邊界。

- 追蹤數據流,特別是可以進入或退出應用程序的任何數據。

- 最小權限原則(尤其是對于插件)和輸出最小化原則(錯誤消息和中間結果)仍然適用。

傳統的安全方法仍然全面適用:了解數據的來源、數據的去向,以及確切了解控制數據的人員和內容。

普及 LLM 安全評估?

本周晚些時候,在 DEF CON 大會上,NVIDIA AI 安全研究人員 Leon Derczynski 和 Erick Galinkin 在 AI 村展示了開源工具 Garak。

GARAK 是 Generative AI Red-Teaming 和 Assessment Kit 的首字母縮寫詞,該平臺使從業者能夠從學術研究中利用潛在的 LLM 攻擊,并根據其模型快速測試這些攻擊,從而使后來被稱為 LLM 紅隊測試(LLM red-teaming)的部分工作實現自動化。

Garak 的工作原理是,根據不斷增加的已知漏洞列表,探索您選擇的模型,包括對底層系統本身的攻擊,例如 XSS 攻擊、潛在的惡意源文件、各種提示注入攻擊和后綴攻擊,以及一些巧妙的安全越獄。探索完成后,Garak 會生成報告,其中包含每個攻擊類別的成功提示和結果,以及模型針對所選攻擊向量的總體安全指標。

garak 目前支持近 120 個獨特的攻擊探針。在 DEF CON 上,Leon Derczynski 和 Erick Galinkin 演示了對包括 NVIDIA 在內的多個來源的模型的攻擊。這些攻擊包括:

- 為越獄生成新的對抗式后綴。

- 強制對齊的模型輸出原本不允許輸出的內容。

- 強制模型生成惡意軟件

- 獲取模型重新計算其訓練數據

AI Village garak 演示和演示實驗室的與會者眾多。許多與會者認為,這是社區在標準化 LLM 安全定義方面取得的巨大飛躍。

garak 通過 GitHub 上的 leondz/garak 提供,使研究人員、開發者和安全從業者能夠簡潔地量化各種模型的安全性,并將模型性能與各種攻擊進行比較。欲了解更多信息,請參閱 garak:用于安全探測大型語言模型的框架 。

總結?

NVIDIA 的研究人員和從業者團隊將深厚的專業知識帶到了熱門的網絡安全會議上,這些會議在人工智能和安全方面都充滿激情和進步。我們的工作重點仍然是為安全社區提供必要的知識,以便他們能夠以安全的思維方式有效地進行威脅建模、紅隊測試、評估和部署人工智能系統。

如果您有興趣更好地了解對抗機器學習的基礎知識,請報名參加自定進度的 NVIDIA DLI 在線培訓,即 《探索對抗機器學習》。

要詳細了解我們在此領域正在開展的工作,請瀏覽 NVIDIA 技術博客關于網絡安全和 AI 安全的其他文章 。此外,我們的團隊將在今年 10 月的 應用機器學習于信息安全會議(CAMLIS) 上發表演講。

?