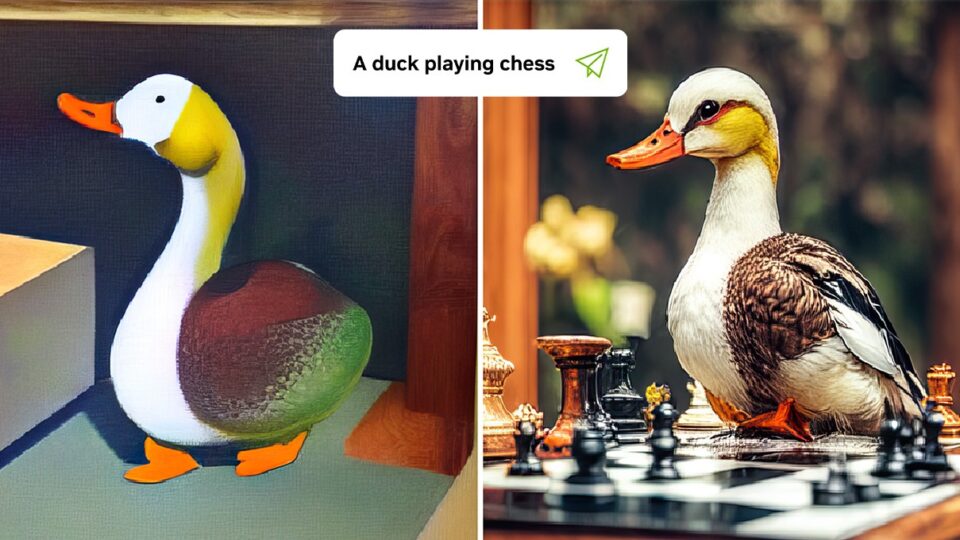

新的研究正在提升人工智能的創造力,通過文本引導的圖像編輯工具。這項研究提出了一種使用即插即用擴散特征(PnP-DF)的框架,可以指導真實和精確的圖像生成。視覺內容創作者可以通過一個提示圖像和幾個描述性單詞,將圖像轉換為視覺效果。

可靠而輕松地編輯和生成內容的能力有可能擴大藝術家、設計師和創作者的創作可能性。它還可以加強依賴動畫、視覺設計和圖像編輯的行業。

“最近的文本到圖像生成模型標志著數字內容創作進入了一個新時代。然而,將它們應用于現實世界應用程序的主要挑戰是缺乏用戶可控性,這在很大程度上被限制為僅通過輸入文本來指導生成。我們的工作是為用戶提供對圖像布局控制的首批方法之一,” Narek Tumanyan 說,魏茨曼科學研究所的主要作者和博士候選人。

最近在生成人工智能方面的突破為開發強大的文本到圖像模型開辟了新的途徑。然而,復雜性、模糊性和對自定義內容的需求限制了當前的渲染技術。

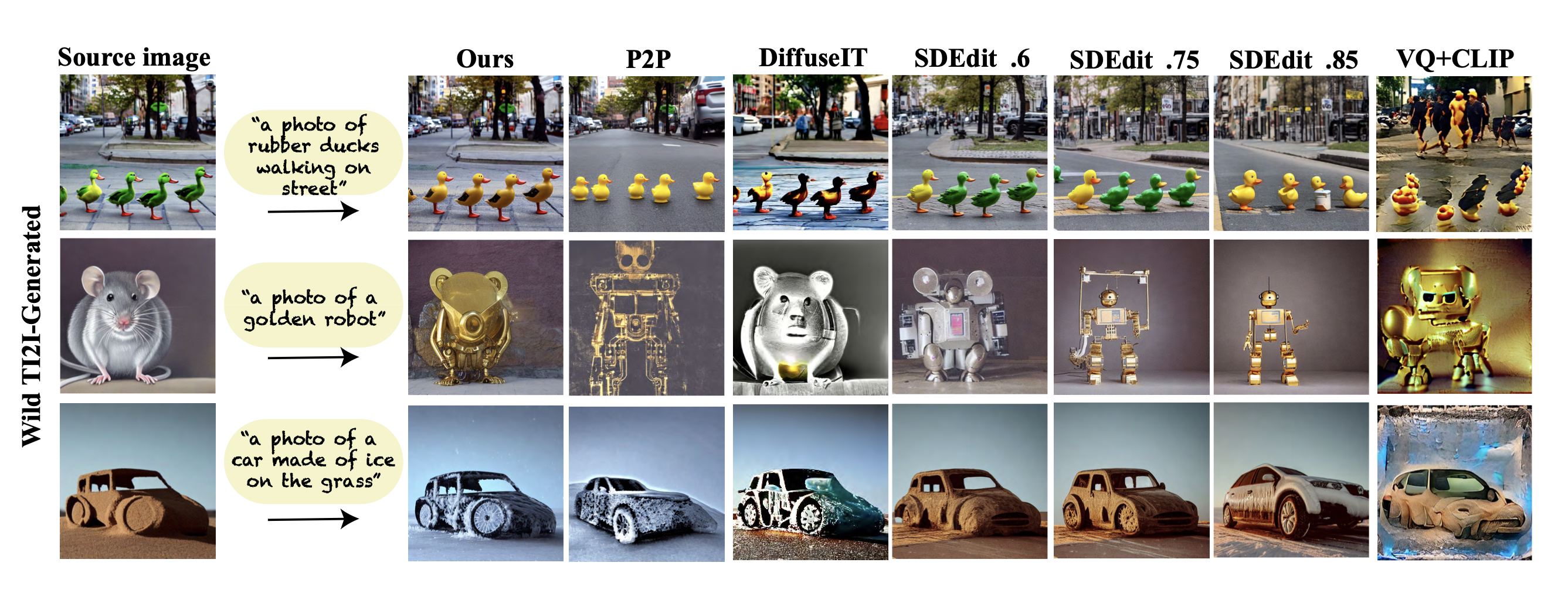

該研究介紹了一種使用 PnP DFs 的新方法,該方法改進了圖像編輯和生成過程,使創作者能夠更好地控制其最終產品。

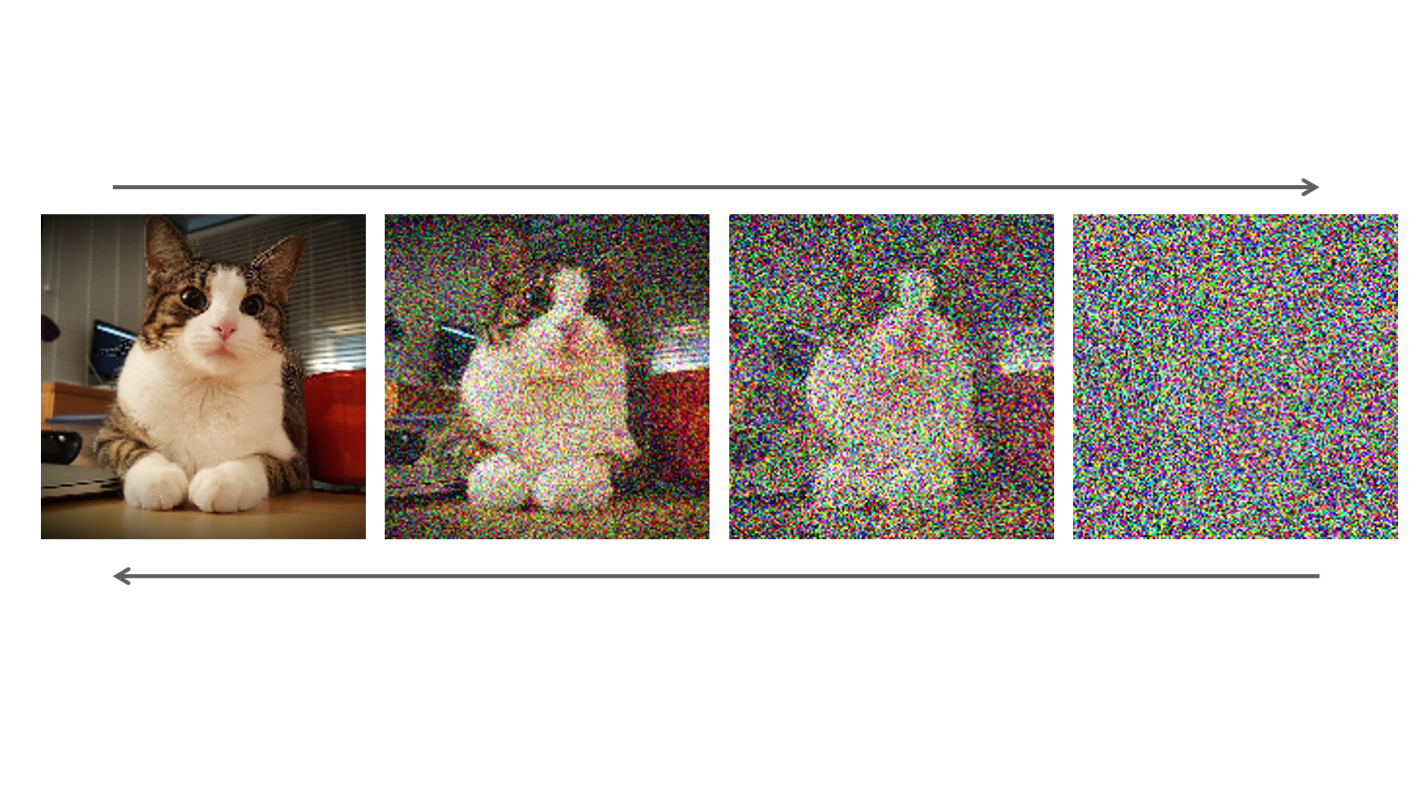

研究人員從一個簡單的問題開始:擴散模型是如何表示和捕捉圖像的形狀或輪廓的?該研究探索了圖像在生成過程中的內部表征,并考察了這些表征如何編碼形狀和語義信息。

新方法控制生成的布局,而無需訓練新的擴散模型或對其進行調整,而是通過理解空間信息是如何在預訓練的文本到圖像模型中編碼的。在生成過程中,模型從引入的引導圖像中提取擴散特征,并將其注入生成過程的每個步驟,從而對新圖像的結構進行細粒度控制。

通過結合這些空間特征,擴散模型對新圖像進行細化,以匹配制導結構。它迭代地執行這一操作,更新圖像特征,直到它降落在最終圖像上,該圖像保留了指南圖像布局,同時也匹配了文本提示。

作者寫道:“這產生了一種簡單有效的方法,將從制導圖像中提取的特征直接注入到翻譯圖像的生成過程中,不需要訓練或微調。”。

這種方法為更先進的受控生成和操作方法鋪平了道路。

研究人員利用 cuDNN 加速 PyTorch 框架,在 NVIDIA A100 GPU 平臺上開發和測試了 PNP 模型。據該團隊稱,GPU 的大容量使他們能夠專注于方法開發。研究人員獲得 A100 的支持,是因為他們參與了 NVIDIA Applied Research Accelerator Program。

該框架部署在 A100 上,在大約 50 秒內從引導圖像和文本轉換出新圖像。

這個過程不僅有效而且可靠,可以準確地生成令人驚嘆的圖像。它還可以超越圖像,翻譯草圖、繪圖和動畫,并可以修改照明、顏色和背景。

他們的方法也優于現有的文本到圖像模型,在保留制導布局和偏離其外觀之間實現了卓越的平衡。

然而,該模型確實存在局限性。當編輯具有任意顏色的圖像部分時,它不能很好地執行,因為模型不能從輸入圖像中提取語義信息。

研究人員目前正致力于將這種方法擴展到文本引導的視頻編輯中。這項工作也被證明對其他利用擴散模型中圖像內部表示分析能力的研究有價值。

例如,一項研究利用團隊的研究見解來改進計算機視覺任務,如語義點對應。另一個重點是擴大文本到圖像生成控制,包括對象的形狀、位置和外觀。

來自魏茨曼科學研究所的研究小組將在CVPR 2023上發表這項作品,該作品也在GitHub上開源。

想要了解更多關于團隊的信息,請訪問 項目頁面。

閱讀研究報告 Plug-and-Play Diffusion Features for Text-Driven Image-to-Image Translation。

觀看 NVIDIA 研究 在 CVPR 2023 上實現的人工智能突破。

?