新發布的由 8B、70B 和 405B 大型語言模型 (LLM) 組成的 Llama 3.1 集合正在縮小專有模型和開源模型之間的差距。由于其開放性,更多開發者和企業被吸引將這些模型集成到其 AI 應用中。

這些模型擅長處理各種任務,包括內容生成、編碼和深度推理,并可用于為聊天機器人、自然語言處理和語言翻譯等用例的企業應用提供支持。

由于 Llama 3.1 405B 模型的訓練數據量龐大,因此非常適合生成合成數據來調整其他語言模型。這在醫療健康、金融和零售等行業尤其有用,因為這些行業由于合規性要求而無法獲得真實數據。

此外,Llama 3.1 405B 還可以使用特定領域的數據進行調整,以服務于企業用例。

一旦企業定制語言模型(LLM)以適應其組織要求(包括領域知識和技能、公司詞匯和其他文化差異),其準確性會得到提升。

使用 NVIDIA AI Foundry 構建自定義生成式 AI 模型

NVIDIA AI Foundry 是一個平臺和服務,用于使用企業數據和特定領域的知識構建自定義生成式 AI 模型。與臺積電制造其他公司設計的芯片類似,NVIDIA AI Foundry 使組織能夠開發自己的 AI 模型。

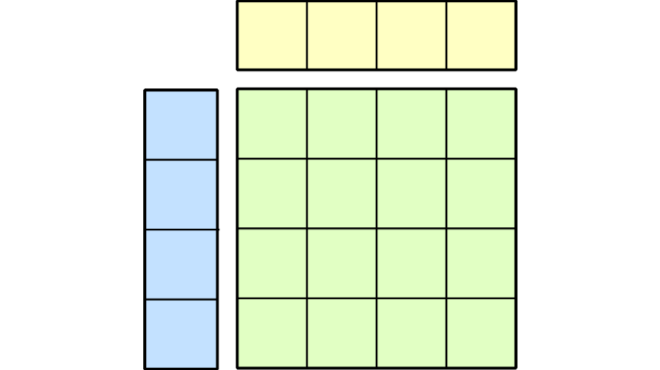

芯片代工廠提供先進的晶體管技術、制造流程、大型芯片晶圓廠、專業知識以及由第三方工具和庫提供商組成的豐富生態系統。同樣,NVIDIA AI Foundry 包括 NVIDIA 創建的 AI 模型(如 Nemotron 和 Edify)、熱門的開放 foundation models, NVIDIA NeMo 軟件用于自定義模型,以及由 NVIDIA AI 專家構建和支持的 NVIDIA DGX Cloud—built 和 backed 由 NVIDIA AI 專家。

該 Foundry 輸出打包為 NVIDIA NIM 推理微服務的性能優化自定義模型,以便在任何加速云、數據中心和工作站上輕松部署。

在此博客中,我們將深入探討如何創建自定義語言模型(LLM)。您可以將其用作參考,以創建其他自定義生成式 AI 模型,例如多模態語言模型、視覺語言模型或文本轉圖像模型。

使用 Llama 3.1 生成專有的合成域數據

由于合規性和安全性要求,企業通常需要克服由于數據缺乏或數據不可訪問性帶來的問題。

Llama 3.1 405B 模型由于具有增強的能力,能夠識別復雜模式、生成高質量數據、良好泛化、高效擴展、減少偏差并保護隱私,因此非常適合用于合成數據生成。

Nemotron-4 340B Reward 模型會判斷 Llama 3.1 405B 模型生成的數據,并對不同類別的數據進行評分,從而過濾掉評分較低的數據,并提供符合人類偏好的高質量數據集(圖 2).

該獎勵模型以總分 92.0 實現了一流的性能,在RewardBench 排行榜上名列前茅。它在“聊天困難”子集方面表現出色,該子集測試模型處理技巧問題和指令響應中細微差別的能力。

此外,這些模型還為企業提供了在商業應用中自由使用生成的數據集的許可證。

數據集準備就緒后,它可以使用 GitHub 上的 NeMo Aligner 庫微調其他基礎模型。

使用 NVIDIA NeMo 篩選、定制和評估模型

NVIDIA NeMo 是一個端到端平臺,可隨時隨地開發自定義生成式 AI。它包括用于訓練、自定義和檢索增強生成(RAG)的工具、護欄和工具包、數據管護工具以及模型預訓練,為企業提供了一種簡單、經濟高效且快速的采用生成式 AI 的方法。

在本文中,我們將向您展示如何使用 AI Foundry 創建自定義 Llama 3.1 模型。關鍵步驟包括特定領域的數據準備、LLM 自定義和評估。

特定領域的數據準備

生成合成數據后,您可以迭代地使用 NeMo Curator 來整理高質量數據并提高自定義模型的性能。例如,如果一家公司想構建一個擅長回答法律問題的模型,它可以使用 Llama 3.1 405B 模型的合成數據生成流程來創建逼真的問答對。

問答對示例如下所示:

{

"question": "Which government department is responsible for setting design and signage standards for federally funded highways in the US?",

"answer": "The U.S. Department of Transportation sets uniform design and signage standards for federally funded highways, which most states adopt for all roads."

}查看此 NeMo Curator notebook,詳細了解如何生成合成數據并使用質量過濾、語義去重和 HTML 標簽剝離等過濾技術。

NeMo Curator 可以跨數千個計算核心無縫擴展,并使用高度優化的 CUDA 內核輕松執行各種數據采集、預處理和清理任務,使企業開發者能夠節省時間并更快地創建高質量數據。

NeMo Curator 提供各種開箱即用的功能,例如文本清潔、語言識別、質量過濾、隱私過濾、域和毒性分類、去重和簡化的可擴展性。這些功能使開發者能夠創建用于自定義的高質量數據。

自定義和評估

準備好數據后,開發者可以使用 NeMo 輕松自定義和評估模型,以獲得滿足其特定需求的最佳模型。NeMo 利用先進的并行技術最大限度地提高 NVIDIA GPU 性能,幫助企業快速開發解決方案。它可以跨多個節點有效管理 GPU 資源和內存,從而提高性能。通過將模型和數據分割,NeMo 實現了流暢的多節點和多 GPU 訓練,減少訓練時間并提高工作效率。

下表顯示了在 NVIDIA H100 GPU 上使用 NeMo 的 Llama 3.1 405B 模型的預訓練性能。為實現此性能,我們使用了以下參數:微批量大小為 1,全局批量大小為 253,張量并行為 8,管線并行為 9,虛擬并行為 7,上下文并行為 2。

在預訓練方面,與 BF16 相比,使用 FP8 可以實現約 56.5% 的吞吐量(每秒令牌數)提升。

| 模式 | 精度 | *GPU | 測序 | 令牌/秒/GPU | TFLOP/秒/GPU | 在 1000 個 GPU 上訓練 10T 令牌所需時間 (天) |

| 預訓練 | BF16 | 576 | 8192 | 192 | 512 | 600 |

| 預訓練 | FP8 | 576 | 8192 | 802 | 802 | 369 |

同樣,對于 LoRA 微調,與 BF16 相比,FP8 可以實現約 55% 的性能提升。

為實現此性能,我們使用了以下參數:微批量大小為 1,全局批量大小為 24,張量并行為 4,管線并行為 6,虛擬并行為 7,上下文并行為 1。為實現上述性能,請參閱我們文檔中的預訓練或微調 LLaMA 3.1 指南。

| 模式 | 精度 | *GPU | 測序 | 令牌/秒/GPU | TFLOP/秒/GPU | 只需幾分鐘即可完成訓練 (1000 萬個令牌) |

| LoRA | BF16 | 24 | 2048 | 376 | 621 | 18.5 |

| LoRA | FP8 | 24 | 2048 | 583 | 962 | 11.9 |

NeMo 支持多種參數高效的微調技術,例如 p-tuning、低秩適應(LoRA)及其量化版本(QLoRA)。這些技術有助于創建自定義模型,而無需大量計算能力。

除了這些參數高效的微調技術之外,NeMo 還支持監督式微調(SFT)和比對技術,例如從人類反饋中進行強化學習(RLHF)、直接偏好優化(DPO)和 NeMo SteerLM。這些技術能夠指導模型響應并使其與人類偏好保持一致,從而使大語言模型(LLMs)隨時可以集成到面向客戶的應用中。

為了簡化生成式 AI 自定義,NVIDIA NeMo 團隊宣布了 NVIDIA NeMo Customizer 微服務的搶先體驗計劃。這項高性能、可擴展的服務簡化了針對特定領域用例的大語言模型微調和對齊。使用知名微服務和 API 架構,幫助企業更快地將解決方案推向市場。

使用 LLM 的企業應定期針對新舊任務對其進行測試。自定義這些模型可能會導致它們忘記先前的知識,這個問題被稱為“災難性遺忘”。為了保持模型良好運行并改善用戶體驗,公司必須不斷優化模型,對其進行基本技能的重新測試,確保與公司目標保持一致,并檢查是否有任何先前的能力損失。

為簡化 LLM 評估,NVIDIA 提供對 NeMo Evaluator 微服務 的早期訪問,該服務支持:

- 自動評估基于一套精心策劃的學術基準。

- 使用用戶提供的評估數據集進行自動評估。

- 使用 LLM 作為判斷對模型響應執行整體評估,這對于可能未定義真值的生成任務非常相關。

要開始使用,請申請NeMo Evaluator 搶先體驗。 在此期間,您可以使用 NeMo 框架對 Exact Match、F1 和 ROUGE 等指標執行評估。

為了針對法律領域定制模型,開發者首先整理數據。然后,他們使用 NeMo 應用 LoRA 技術。這增強了 Llama 3.1 8B 模型更有效地響應法律問題的能力。查看此 notebook,了解如何使用 LoRA 微調 Llama 3.1 模型的詳細說明。

連接企業數據以獲取見解

NVIDIA NeMo Retriever 是一組生成式 AI 微服務,使組織能夠將自定義模型無縫連接到多樣化的業務數據,并提供高度準確的響應。NeMo Retriever 提供世界級的信息檢索,具有高準確性的檢索流程和最大的數據隱私,使組織能夠更好地利用其數據并實時生成業務見解。

NeMo Retriever 利用企業級 RAG 功能改進生成式 AI 應用,無論業務數據位于何處,都可將其連接到該數據。NeMo Retriever 提供先進的開放和商業檢索流程,可將企業文本 QA 評估的錯誤答案減少 30%。了解如何使用 NeMo Retriever 構建 RAG 驅動的應用構建 RAG 驅動的應用。

保護 LLM 響應

借助 NVIDIA NeMo Guardrails,開發者可以向基于語言模型(LLM)的對話式應用添加可編程護欄,確保對話的可靠性、安全性和可控性,同時抵御常見的語言模型漏洞。

NeMo Guardrails 是一個可擴展的工具包,旨在與第三方和社區護欄以及安全模型(例如 Meta 的最新 Llama Guard)集成。它還可以與熱門的 LLM 應用開發框架(例如 LangChain 和 LlamaIndex)一起使用。了解如何開始使用 NeMo Guardrails。

借助 NVIDIA NIM 實現高性能推理

AI Foundry 的自定義模型可以打包為 NVIDIA NIM 推理微服務(NVIDIA AI Enterprise 的一部分),以便在云、數據中心和工作站中安全、可靠地部署高性能推理。它支持各種 AI 模型(包括開放式基礎模型),并使用行業標準 API 確保無縫、可擴展的 AI 推理。

隨時隨地使用 NIM 在 NVIDIA 加速基礎設施上通過單個命令或 Kubernetes 上的自動擴展進行本地部署。從 NIM 部署的簡單指南 開始。此外,NIM 還支持使用 LoRA 自定義模型的部署。

開始構建自定義模型

根據您在人工智能旅程中所處的位置,您可以通過不同的方式開始。

- 要為您的企業構建自定義 Llama NIM,請查看Llama 3.1 NIM 自定義筆記本。

- 在 ai.nvidia.com 上體驗新的 Llama 3.1 NIM 和其他熱門基礎模型。你可以直接訪問模型端點,也可以下載 NIM 并在本地運行。

- 獲取幫助訪問和設置云端基礎設施,以運行 Llama 3.1 NIM 或其他用于評估和原型設計的模型。

- 詳細了解 NVIDIA AI Foundry單擊此處。

?