Posts by Ashwin Nanjappa

數據中心/云端

2025年 4月 2日

NVIDIA Blackwell 在 MLPerf Inference v5.0 中實現巨大的性能飛躍

在不斷增長的模型大小、實時延遲要求以及最近的 AI 推理的推動下, 大語言模型 (LLM) 推理的計算需求正在快速增長。與此同時,

3 MIN READ

數據中心/云端

2024年 8月 28日

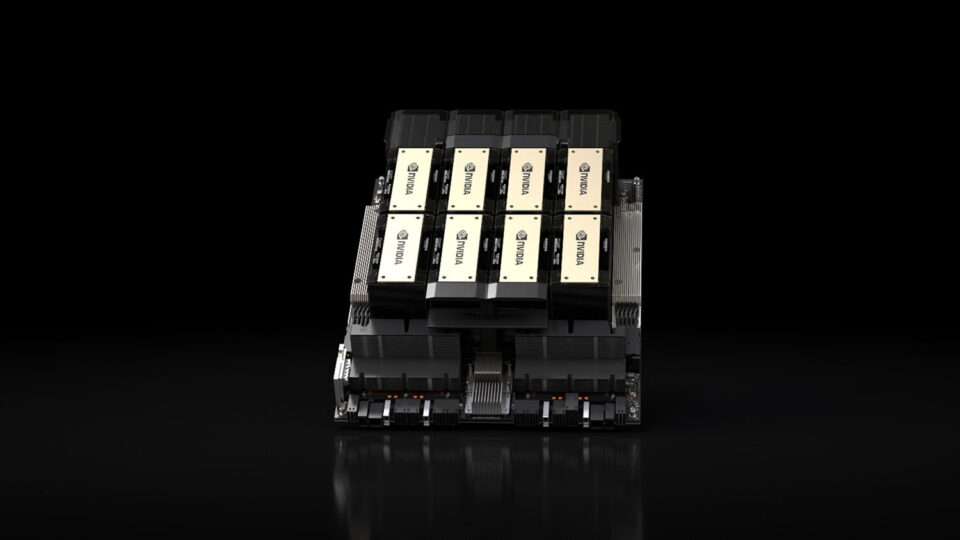

NVIDIA Blackwell 平臺在 MLPerf Inference v4.1 中創下新的 LLM 推理記錄

大型語言模型 (LLM) 推理是一項全棧挑戰。實現高吞吐量、低延遲推理需要強大的 GPU、高帶寬 GPU 之間的互連、

4 MIN READ

數據中心/云端

2024年 3月 27日

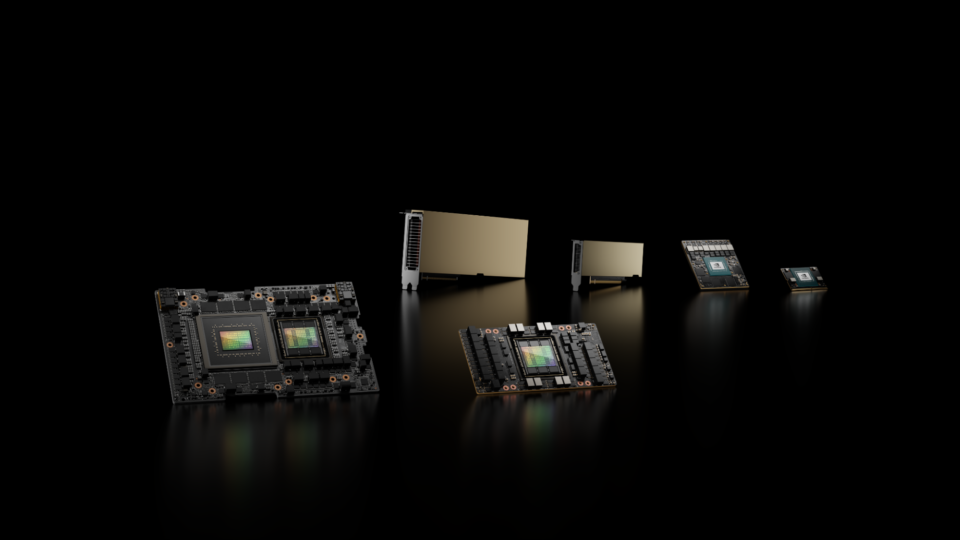

NVIDIA H200 Tensor Core GPU 和 NVIDIA TensorRT-LLM 集 MLPerf LLM 推理記錄

隨著生成式 AI 模型的持續創新,生成式 AI 在計算應用方面取得了巨大進步,從而大幅增強人類能力。這些模型包括 生成式 AI 模型,

3 MIN READ

數據中心/云端

2023年 9月 11日

NVIDIA GH200 Grace Hopper 超級芯片首次亮相,取得領先的 MLPerf 推理 v3.1 結果

人工智能正在改變計算方式,推動AI在全球范圍內的應用部署。智能聊天機器人、圖像和視頻合成的簡單文本提示、

4 MIN READ

網絡/通訊

2023年 7月 6日

新的 MLPerf 推理網絡部門展示 NVIDIA InfiniBand 和 GPUDirect RDMA 功能

在 MLPerf Inference v3.0 中,NVIDIA 首次向新推出的 網絡分割 投入,

3 MIN READ

數據中心/云端/邊緣

2023年 4月 5日

通過 AI 的全棧優化在 MLPerf 推理 v3.0 中創下新紀錄

目前最令人興奮的計算應用程序依賴于在復雜的人工智能模型上進行訓練和運行推理,通常是在要求苛刻的實時部署場景中。需要高性能、

5 MIN READ