Inference Performance

2025 年 4 月 10 日

NVIDIA のフルスタック ソリューションで AI 推論のパフォーマンスを最適化

NVIDIA は、AI 推論の可能性を再定義し、これまで以上に高速で、効率的かつ拡張可能なソリューションを提供するために、フルスタックのイノベーションを通じて開発者を支援しています。

2 MIN READ

2024 年 11 月 8 日

NVIDIA TensorRT-LLM の KV Cache Early Reuseで、Time to First Token を 5 倍高速化

KV キャッシュの再利用技術と、TTFT のさらなる高速化を実現するベストプラクティスについて解説します。

2 MIN READ

2024 年 10 月 28 日

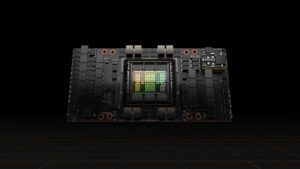

NVIDIA GH200 Superchip が、Llama モデルとのマルチターン インタラクションの推論を 2 倍高速化

NVIDIA GH200 Grace Hopper Superchip を活用し、システム スループットを犠牲にすることなく、x86 ベースの NVIDIA H100 サーバーと比較して、Llama 3 70B モデルでマルチターンでユーザーとのやり取りする場合、TTFT を最大 2 倍に向上させる方法について解説します。

2 MIN READ