世界中の企業が生成 AI モデルの恩恵を実感しています。チャットボット、バーチャル アシスタント、コーディング コパイロットなど、さまざまなアプリケーションで生成 AI モデルが競うように導入されています。

汎用モデルは単純なタスクには適していますが、さまざまな業界特有のニーズに応えるには不十分です。カスタム生成 AI モデルは、ドメイン固有の知識を取り入れ、地域の文化的ニュアンスを理解し、ブランドの聲や価値観に合わせることで、一般的な AI モデルを凌駕し、企業の要件を満たします。

NVIDIA NeMo チームがマイクロサービスである NVIDIA NeMo Curator、NVIDIA NeMo Customizer、NVIDIA NeMo Evaluator の早期アクセス プログラムをお知らせします。データのキュレーションとカスタマイズから評価まで、開発のあらゆる段階をカバーするこれらのマイクロサービスは、カスタム生成 AI モデルを構築する利用者のためにプロセスをシンプルにします。

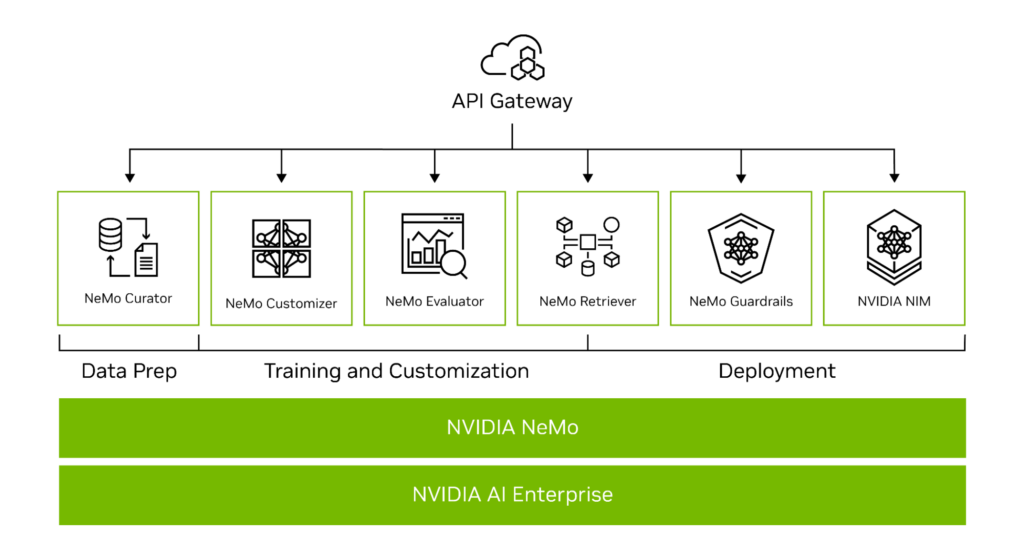

NVIDIA NeMo は、場所を問わずカスタム生成 AI を開発するためのエンドツーエンド プラットフォームです。トレーニング、ファインチューニング、検索拡張生成、ガードレール、データ キュレーションのためのツールと事前學習済みモデルが含まれています。フレームワークから上位 API エンドポイントまで、テクノロジ スタック全體に対応しています (図 1)。

NVIDIA CUDA-X マイクロサービスに含まれる NeMo API エンドポイントは、NVIDIA ライブラリをベースに開発されており、企業はカスタム生成 AI の構築を簡単に始められます。

カスタム生成 AI のための開発マイクロサービス

この早期アクセス プログラムでは、開発者はマイクロサービスである NeMo Curator、NeMo Customizer、NeMo Evaluator へのアクセスを申請することができます。これらのマイクロサービスを組み合わせることで、企業はエンタープライズ グレードのカスタム生成 AI を構築し、ソリューションの市場投入を加速することができます。

NeMo Curator マイクロサービスは、LLM の事前トレーニングとファインチューニングのためのデータ キュレーションで開発者を支援し、NeMo Customizer はファインチューニングとアライメントを可能にします。最後に、NeMo Evaluator を利用することで、開発者はアカデミック ベンチマークやカスタム ベンチマークを用いてモデルを評価し、改善の余地がある領域を特定できます。

以下、これらのマイクロサービスについて説明します。

NeMo Curator

NeMo Curator は GPU で高速化可能なスケーラブルなデータ キュレーション マイクロサービスで、生成 AI モデルの事前トレーニングとカスタマイズのために高品質なデータセットを準備します。Curator は、データ ダウンロード、テキスト抽出、クリーニング、品質フィルタリング、厳密/ファジィ重複除去、多言語ダウンストリーム タスクの除染などのデータ キュレーション タスクを合理化します。

Curator は以下をサポートしています。

- Supervised Fine-Tuning (SFT)、P-tuning、Low-Rank Adaptation (LoRA) などのファインチューニング用にプロンプトをフォーマット化。

- 以下のようなさまざまなメタデータ分類子をサポートするデータ アノテーション向けの高速なパイプライン。

- 醫療や法律など、さまざまなドメインのためのドメイン分類子。開発者は、モデル開発、データ ブレンド、生データの強化のために、ドメイン固有のカスタマイズに最も関連性の高いデータを使用できます。

- 個人識別情報 (PII) 検出。大規模なトレーニング データから PII 情報を編集または削除し、データ プライバシーを遵守します。

- 毒性フィルター。定義済みのカスタム フィルターとカスタム カテゴリを使用し、無関係で有毒なデータを特定し、削除します。

NeMo Customizer

NeMo Customizer は、ドメイン固有のユース ケースに合わせた LLM のファインチューニングとアライメントを簡素化する、高性能で拡張性の高いマイクロサービスです。このマイクロサービスは現在、LoRA と p-tuning という、2 つの一般的な Parameter-Efficient Fine-Tuning (PEFT) 手法をサポートしています。

加えて、NeMo Customizer マイクロサービスには今後、以下のアライメント手法をサポートする予定です。

- SFT

- RLHF (Reinforcement Learning from Human Feedback/人間のフィードバックによる強化學習)

- DPO (Direct Preference Optimization/直接優先最適化)

- NVIDIA NeMo SteerLM

NeMo Customizer マイクロサービスは、Kubernetes をサポートし、NFS のようなファイル システムと Volcano スケジューラーによるデプロイに対応しています。これにより、LLM の高性能なマルチノード ファインチューニングに一般的に必要とされるバッチ スケジューリングが可能になります。

NeMo Evaluator

特定のタスクに合わせて LLM をカスタマイズすると、以前に學習したタスクを忘れるという、破滅的な忘卻が生じる可能性があります。LLM を使用する企業は、元のタスクと新しいタスクの両方でパフォーマンスを評価し、モデルを継続的に最適化してエクスペリエンスを改善する必要があります。NeMo Evaluator は、あらゆるクラウドやデータ センター上で、さまざまなアカデミック ベンチマークやカスタム ベンチマークによってカスタム生成 AI モデルを自動評価します。

Beyond the Imitation Game Benchmark (BIG-Bench)、Multilingual、BigCode Evaluation Harness、Toxicity など、厳選されたアカデミック ベンチマークによる自動評価がサポートされています。

NeMo Evaluator はカスタム データセットでの評価をサポートしており、精度、ROUGE (Recall-Oriented Understudy for Gisting Evaluation)、F1、完全一致などの指標を提供します。

また、LLM-as-a-judge を使用し、モデルの応答を包括的に評価することもできます。NVIDIA API カタログで提供されている NVIDIA NIM でサポートされている LLM を活用すれば、MT-Bench データセットでモデルの応答を評価することができます。

カスタム 生成 AI を簡単に構築する

NeMo マイクロサービスは、パフォーマンスの高速化や拡張性など、NeMo プラットフォームの利點を余すところなく提供します。開発者は、並列処理手法を活用し、必要に応じてマルチ GPU やマルチノードにスケーリングすることで、トレーニング パフォーマンスを高速化できます。

マイクロサービスはまた、オンプレミスからクラウドまで好みのインフラで実行できるため、データ セキュリティの制御、ベンダー ロックインの回避、コスト削減といったメリットを企業にもたらします。

開発スタックに何を選ぶのかに関係なく、マイクロサービスは適応性と互換性を提供します。現行のワークフローに API として簡単に組み込むことができるため、どのようなテクノロジを使用しているか心配する必要もありません。

早期アクセスを申し込む

NeMo マイクロサービスの早期アクセスに是非お申し込みください。申請はケースによって審査されることがあります。承認されると、マイクロサービス コンテナーにアクセスするためのリンクが送信されます。

関連情報

- GTC セッション:?A New Class of Cloud-Native Applications at the Far Edge With Generative AI

- GTC セッション:?Customizing Generative AI with Your Own AI Foundry

- GTC セッション:?Enhancing the Digital Human Experience with Cloud Microservices Accelerated by Generative AI

- SDK:?NeMo Retriever

- SDK:?NeMo LLM Service

- SDK:?NeMo Inferencing Microservice